Google blocca Gemini: addio gentilezza, arriva GPT-5.2 e cambia le regole del gioco

Limiti delle API e la fine della “cortesia” di Google

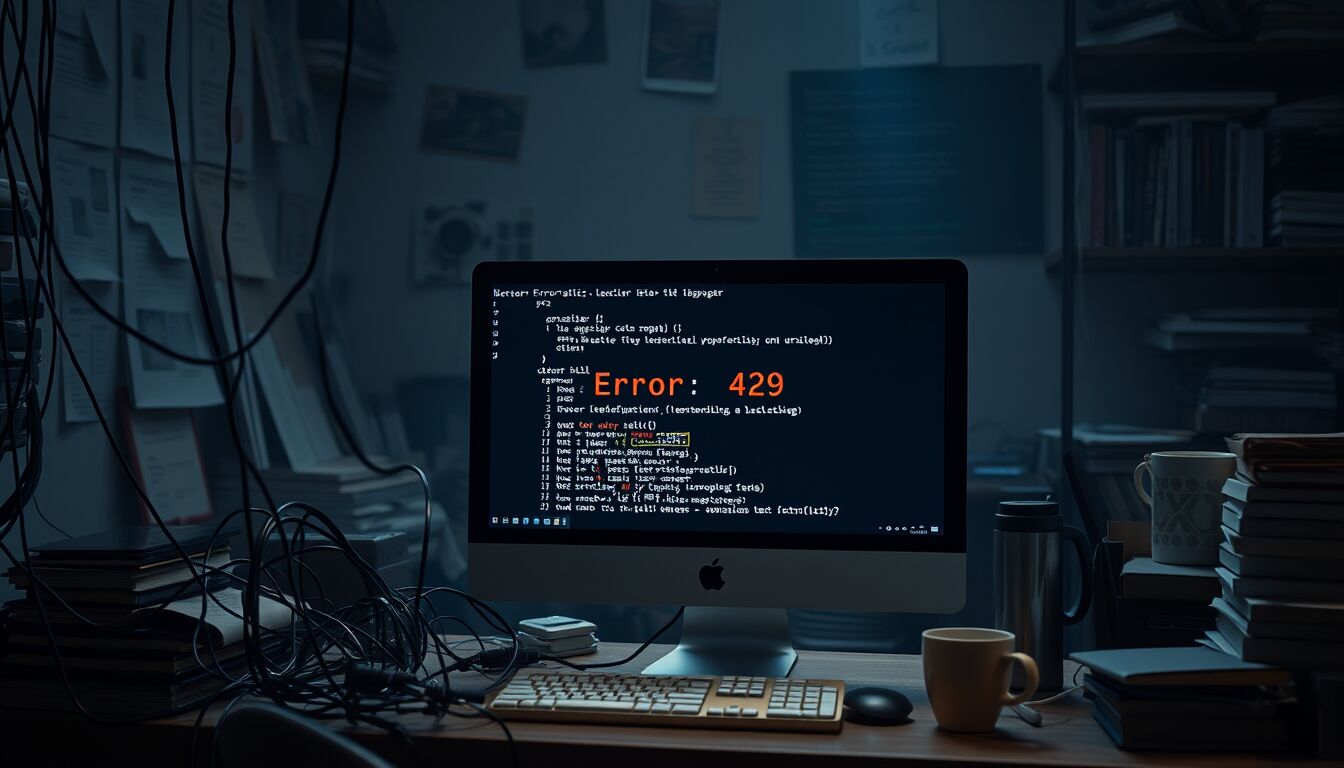

Google ha ridotto in modo drastico il tetto giornaliero delle API gratuite di Gemini 2.5 Flash, passando da 250 a 20 richieste. Un taglio netto che ha interrotto migliaia di micro-automazioni costruite su piattaforme come n8n o su script artigianali, generando in cascata errori 429 per superamento dei limiti. Non si tratta di un semplice ritocco tecnico: è l’indicatore di un cambio di fase. La stagione della “cortesia” — in cui l’accesso generoso alle risorse di calcolo serviva anche a raccogliere segnali d’uso e a far crescere l’ecosistema — lascia spazio a una politica di selezione e rendimento, orientata al ROI.

La mossa arriva mentre Gemini 3 Pro consolida capacità credibili, ma il contesto competitivo si è surriscaldato: OpenAI ha accelerato con ChatGPT 5.2 e ha attivato una modalità da “codice rosso” per aumentare qualità e velocità di rilascio. In questo scenario, Mountain View segnala la fine del “pranzo gratis” e alza l’asticella per gli utenti del livello free di Google AI Studio, indirizzandoli — di fatto — verso i piani a pagamento. Fonti interne parlano di una misura anti-abusi e anti-frodi; la lettura industriale è più ampia: razionalizzare i costi di inferenza e rafforzare la sostenibilità del prodotto mentre la concorrenza spinge su prestazioni e affidabilità.

Per chi ha costruito workflow leggeri e prototipi sul tier gratuito, il cambio è stato immediato e poco annunciato. L’effetto è duplice: riduce l’uso opportunistico che stressa l’infrastruttura e, contemporaneamente, seleziona gli utenti disposti a migrare su offerte premium. Il segnale al mercato è chiaro: la fase evangelica è archiviata; l’accesso alle capacità di Gemini si normalizza secondo logiche di costo, priorità e valore generato.

Strategie di monetizzazione e impatto su PMI e sviluppatori

La stretta sul livello free di Google AI Studio rientra in una strategia di monetizzazione esplicita: ridurre la superficie d’uso non pagante, contenere i costi di inferenza e spingere l’adozione dei piani a pagamento. La giustificazione ufficiale — mitigare abusi e frodi — è plausibile, ma l’effetto pratico è un funnel più ripido verso offerte premium e contratti enterprise. Il messaggio agli utenti è inequivoco: i carichi che incidono sui margini devono essere fatturati, anche quando nascono come semplici prototipi.

Per PMI e liberi professionisti, l’impatto è operativo e di governance. Basare automazioni e processi su tier gratuiti introduce un rischio di continuità del servizio non più accettabile. Il taglio delle chiamate ha evidenziato dipendenze critiche mascherate da “sperimentazione” e ha trasformato innocui proof-of-concept in punti di rottura. Gli errori 429 senza preavviso hanno bloccato flussi di integrazione in n8n, task scheduler e microservizi artigianali, costringendo a correzioni urgenti o migrazioni affrettate.

Il perimetro del rischio non si limita al free tier: anche chi paga può subire cambi di policy o rimodulazioni delle soglie, come dimostrano precedenti nel settore enterprise. La lezione è duplice: pianificare capacità e costi con modelli di chargeback interni e definire contratti che stabiliscano SLA, finestre di preavviso e metriche di consumo verificabili. In assenza di queste tutele, il fornitore resta libero di rinegoziare le regole a ciclo di prodotto in corso.

Per gli sviluppatori, il nuovo contesto impone scelte architetturali più disciplinate. Servono limiti applicativi, caching aggressivo, code di richieste e fallback multi-provider per ridurre l’esposizione a un singolo endpoint. Va adottato il principio del “pay where it matters”: spostare su piani a pagamento i passaggi critici e mantenere il free solo per test non mission-critical. Nel medio periodo, l’obiettivo è un disaccoppiamento pragmatico: astrarre la chiamata al modello tramite layer compatibili e policy di routing che permettano di passare da Gemini a alternative senza refactoring massicci.

Sul fronte finanziario, le PMI dovrebbero trattare l’AI come una voce OPEX ricorrente con soglie di alerta e budget trimestrali, non come un extra “gratuito”. La previsione della spesa, combinata a misure di osservabilità (telemetria su token, latenza, tasso di fallimenti), consente di individuare derive di costo e calcolare il ritorno, distinguendo tra automazioni che generano valore e “nice-to-have” che drenano risorse. In un mercato dove la concorrenza si gioca su qualità e affidabilità, la gratuità non è più un modello operativo: è, al massimo, un trampolino per l’onboarding.

GPT-5.2 e la nuova competizione sulla qualità del ragionamento

OpenAI ha alzato l’asticella con GPT-5.2 nelle varianti Instant, Thinking e Pro, puntando su riduzione degli errori evidenti, stabilità nelle risposte complesse e competenza nel coding. Il confronto non è più solo sulla velocità di inferenza o sul prezzo per token: la metrica decisiva diventa la qualità del ragionamento, dalla scomposizione dei problemi alla coerenza dei passaggi intermedi. La versione Thinking rafforza i passaggi logici espliciti, utile in ambiti che richiedono verificabilità, mentre Instant privilegia latenza bassa per uso conversazionale e integrazioni real-time. Pro bilancia ampiezza del contesto, robustezza e costi di esercizio, mirando a carichi produttivi.

In parallelo, Google spinge su Gemini 3 con una “personalità” meno deferente e più assertiva, come indicato da Demis Hassabis. Il cambio di tono non è un dettaglio stilistico: incide sull’ergonomia del prodotto, sulla gestione dell’ambiguità e sulla capacità del modello di “tenere il punto” in sessioni iterative. La competizione si polarizza così su due direttrici: da una parte la reasoning fidelity rivendicata da OpenAI, dall’altra un’interazione più “dialettica” che Google considera un vantaggio nelle attività collaborative e di problem solving guidato.

Il terreno di prova resta il coding. GPT-5.2 mostra una maggiore disciplina nella generazione di codice eseguibile, nel rispetto dei vincoli di dipendenze e nella manutenzione di progetti multi-file; in scenari ripetitivi riduce le allucinazioni strutturali e migliora la capacità di spiegare i passaggi di debug. Gemini 3 Pro risponde con un rafforzamento della contestualizzazione dei repository e con una gestione più naturale delle richieste che combinano linguaggio naturale, specifiche e snippet preesistenti. La differenza pratica, per ora, si misura in tasso di successo dei test e numero di iterazioni necessarie prima della messa in produzione.

Sul fronte commerciale, ChatGPT mantiene una base utenti ampia, mentre Google integra Gemini nei piani Workspace, riducendo l’attrito al cambio di strumento grazie all’embed nativo nelle suite aziendali. L’esito dipenderà dalla convenienza totale: costo per richiesta utile, tempi di risoluzione, aderenza a requisiti di sicurezza e dati, e garanzie contrattuali. L’abbonamento bundle di Google può trattenere gli utenti per comodità e integrazione, ma la traiettoria di OpenAI sul ragionamento potrebbe spostare le scelte dove contano precisione, auditabilità e tassi di errore minimi.

Resta il tema della velocità di ciclo. Lo stesso Hassabis ha riconosciuto che l’industria passa al modello successivo senza esplorare pienamente le capacità del precedente. Questa accelerazione, sommata al passaggio dalla “cortesia” alla monetizzazione, rischia di creare adozioni superficiali e lock-in affrettati. La differenza competitiva, nei prossimi mesi, non sarà soltanto nella potenza del modello, ma nella capacità di dimostrare affidabilità misurabile: benchmark riproducibili su reasoning, tracciabilità delle catene di pensiero quando richieste e strumenti di controllo per le aziende che devono certificare processi e risultati.

FAQ

- Perché la qualità del ragionamento è diventata centrale nella competizione tra modelli?

Perché incide su accuratezza, affidabilità e riduzione degli errori in compiti complessi, dal coding alla pianificazione, dove conta la coerenza dei passaggi logici. - Quali sono le differenze principali tra GPT-5.2 Instant, Thinking e Pro?

Instant privilegia la bassa latenza, Thinking esplicita i passaggi logici per compiti verificabili, Pro bilancia contesto, stabilità e costi per carichi produttivi. - In che modo Gemini 3 si distingue nell’interazione rispetto a GPT-5.2?

Punta su una personalità meno servile e più assertiva, utile in sessioni iterative e collaborative, mantenendo il focus sulla gestione dell’ambiguità. - Qual è l’impatto pratico di GPT-5.2 sullo sviluppo software?

Riduce allucinazioni strutturali, migliora la generazione di codice eseguibile e rende più efficiente il debug, con meno iterazioni prima del rilascio. - Come influisce l’integrazione di Gemini in Workspace sulle scelte aziendali?

Abbassa l’attrito operativo grazie all’embed nativo negli strumenti di produttività, favorendo continuità e adozione senza migrazioni complesse. - La rapidità di rilascio dei modelli comporta rischi per le aziende?

Sì, può generare lock-in affrettati e adozioni superficiali; servono benchmark riproducibili, SLA chiari e controllo dei costi per governare l’uso in produzione.

DIRETTORE EDITORIALE

Michele Ficara Manganelli ✿

PUBBLICITA’ – COMUNICATI STAMPA – PROVE PRODOTTI

Per acquistare pubblicità CLICCA QUI

Per inviarci comunicati stampa e per proporci prodotti da testare prodotti CLICCA QUI