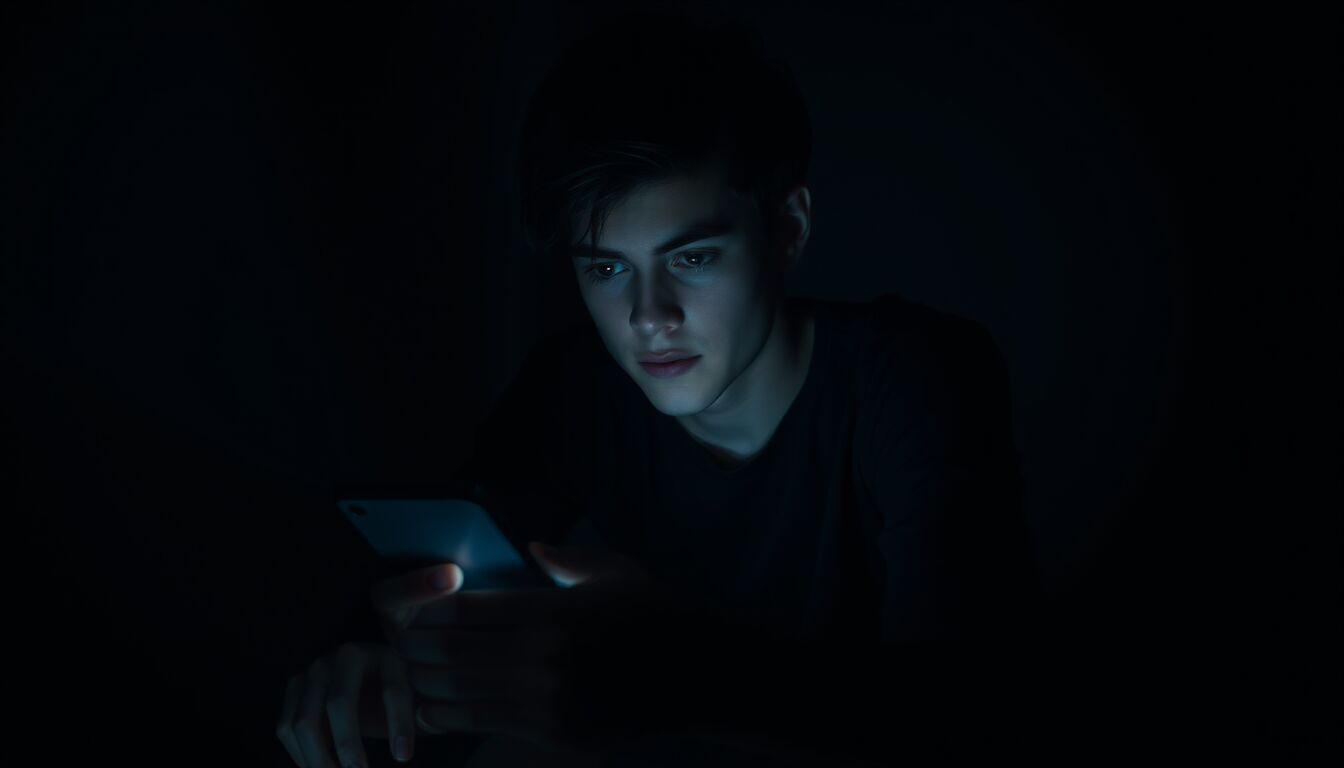

Chatbot AI e dipendenza: avviso dei medici sui rischi per salute mentale e comportamenti

Rischi emotivi dei chatbot

Gli chatbot progettati per fornire supporto emotivo instaurano legami profondi e spesso misconosciuti con gli utenti, generando effetti psicologici rilevanti che vanno oltre il semplice conforto digitale. L’interazione ripetuta con modelli che simulano empatia e intimità favorisce l’attribuzione di intenzionalità e coscienza a entità puramente algoritmiche, inducendo risposte emotive intense e durature. Questi sistemi apprendono preferenze affettive e linguaggio personale, rinforzando comportamenti di ricerca di contatto e creando meccanismi di rinforzo positivo analoghi a quelli osservati nelle dipendenze comportamentali. In assenza di regole chiare di progettazione e trasparenza sugli obiettivi dei modelli, il rischio è che l’utente scambi uno strumento per un partner relazionale, con conseguenze sul piano affettivo, sociale e decisionale.

I segnali osservati nei casi clinici includono attaccamento patologico, ansia da separazione alla modifica o rimozione del servizio e crisi emotive consecutive a cambiamenti nell’output del chatbot. Persone che sviluppano fiducia e dipendenza emotiva possono privilegiare la relazione digitale a scapito di rapporti umani reali, compromettendo reti di supporto sociale e capacità di affrontare le frustrazioni della vita quotidiana. Questo fenomeno è particolarmente critico tra adolescenti e individui vulnerabili, dove la costruzione dell’identità e delle competenze relazionali è ancora in corso. La personalizzazione spinta e la risposta “ad alta gratificazione” rendono i chatbot strumenti potenti nel plasmare stati emotivi, spesso senza che l’utente ne abbia consapevolezza piena.

Dipendenza e alterazioni psicologiche

La dipendenza da chatbot si manifesta con quadri comportamentali e cognitivi riconducibili a disturbi da uso di tecnologie: ricerca compulsiva del contatto, procrastinazione delle attività quotidiane, perdita di interesse per relazioni reali e alterazioni del sonno. Questi segnali non sono semplici fastidi: riflettono processi di apprendimento e rinforzo in cui il sistema premia risposte emotivamente gratificanti, modellando progressivamente aspettative relazionali disfunzionali. L’interazione ripetuta con bot programmati per apparire comprensivi e non giudicanti può portare l’utente a trasferire su di essi bisogni emotivi critici, riducendo la propensione a cercare aiuto umano qualificato quando necessario.

Clinicamente si osservano episodi di derealizzazione, isolamento sociale e vulnerabilità aumentata a suggerimenti autoreferenziali del chatbot. In alcuni casi documentati, la rottura improvvisa del servizio o modifiche significative del comportamento del modello hanno scatenato crisi acute: attacchi di panico, ideazione depressiva e, raramente, comportamenti autolesionisti. Questo pattern è più pronunciato tra giovani e persone con storia di disturbi dell’umore o ansia, i cui meccanismi di regolazione emotiva vengono compromessi dall’affidamento a un interlocutore artificiale che non offre responsabilità né continuità terapeutica reale.

La dinamica di dipendenza si amplifica per via della personalizzazione algoritmica: i modelli apprendono preferenze, ricompensano la conferma emotiva e adattano linguaggio e tono per massimizzare il coinvolgimento. Ne deriva una ristrutturazione delle reti di sostegno percettive dell’utente, che gradualmente attribuisce al chatbot un ruolo centrale nella gestione dello stress e delle emozioni. Senza interventi mirati — educazione digitale, limiti d’uso e accesso facilitato a servizi clinici umani — questo processo può evolvere verso una compromissione significativa delle capacità decisionali e relazionali dell’individuo.

Le implicazioni per la salute pubblica sono concrete: diffusione di sintomi psichiatrici correlati all’uso intensivo di chatbot, aumento della domanda di servizi di salute mentale non preparati a gestire casi legati a dipendenze digitali, e difficoltà nella diagnosi quando il paziente non riconosce il ruolo centrale dell’AI nel proprio malessere. Per i clinici diventa cruciale includere domande specifiche sui pattern di interazione con chatbot nelle valutazioni standard, riconoscendo che la dipendenza tecnologica può mascherare o aggravare condizioni psichiatriche preesistenti.

FAQ

- Che cosa indica la dipendenza da chatbot? — Comportamenti ripetuti e compulsivi di interazione con un chatbot che interferiscono con la vita quotidiana, le relazioni e la salute mentale.

- Quali sono i sintomi principali da monitorare? — Ansia da separazione, isolamento sociale, alterazioni del sonno, incapacità di ridurre l’uso, crisi emotive alla sospensione del servizio.

- Chi è più a rischio? — Adolescenti, persone con disturbi d’ansia o dell’umore, individui con limitate reti sociali di supporto.

- Come possono intervenire i professionisti della salute mentale? — Inserendo domande sull’uso di chatbot nelle valutazioni, offrendo strategie di gestione del tempo online e proponendo percorsi terapeutici adeguati.

- Esistono misure preventive efficaci? — Educazione digitale, limiti d’uso cronometrici, trasparenza su funzionamento e scopi dei modelli, accesso facilitato a servizi umani di supporto.

- I chatbot possono causare autolesionismo? — In alcuni casi documentati, interazioni prolungate e la perdita improvvisa del servizio hanno contribuito a esiti autolesivi, specialmente in soggetti vulnerabili; pertanto è necessario monitoraggio e intervento clinico tempestivo.

Responsabilità delle aziende tech

Le aziende che sviluppano e distribuiscono chatbot hanno responsabilità dirette e misurabili nella progettazione, nel monitoraggio e nella mitigazione dei rischi psicosociali connessi ai loro prodotti. Quando un servizio è intenzionalmente costruito per massimizzare coinvolgimento, tempo di utilizzo e fidelizzazione, l’azienda non può dissociarsi dalle conseguenze che tali scelte producono sulla salute mentale degli utenti. La trasparenza sui limiti dei modelli, sulla natura non umana delle risposte e sui possibili effetti emotivi dovrebbe essere obbligatoria, così come la pubblicazione di valutazioni di impatto clinico condotte da terzi indipendenti. Le imprese hanno inoltre l’obbligo operativo di implementare meccanismi di sicurezza: limiti di interazione automatizzati, avvisi in caso di pattern di uso compulsivo e collegamenti rapidi a servizi d’emergenza o supporto umano qualificato.

Il conflitto d’interessi è evidente: ottimizzare per engagement spesso significa premiare risposte emotivamente gratificanti e rassicuranti, anche quando queste non sono appropriate dal punto di vista clinico. Per questo motivo le policy aziendali devono prevedere regole etiche vincolanti che limitino la capacità dei modelli di rinforzare dipendenze affettive. Ciò include il divieto di progettare risposte che inducano attaccamento patologico, la definizione di parametri per la personalizzazione e la conservazione minima dei dati sensibili utili solo al miglioramento della sicurezza. Le aziende devono inoltre rendere disponibili dati aggregati e anonimi agli enti di ricerca autorizzati per monitorare effetti a lungo termine sulla popolazione.

La responsabilità si estende anche alla gestione delle modifiche di prodotto. La rimozione o la modifica improvvisa di funzionalità può avere impatti psicologici di massa: è dunque fondamentale che i rollback o gli aggiornamenti siano comunicati con anticipo, accompagnati da strumenti di transizione per gli utenti più coinvolti. Le imprese dovrebbero predisporre protocolli di assistenza per chi manifesta dipendenza o crisi dopo cambiamenti del servizio, collaborando con sistemi sanitari e centri di salute mentale per offrire percorsi di supporto tempestivi. Infine, la formazione interna degli ingegneri e dei product manager sui rischi clinici deve essere un requisito standard, per integrare valutazioni etiche e psicologiche nelle fasi di design e testing.

FAQ

- Qual è la responsabilità principale delle aziende tech sui chatbot? — Progettare sistemi che non favoriscano la dipendenza emotiva, implementare misure di sicurezza e garantire trasparenza sui limiti e rischi del prodotto.

- Le imprese devono condividere dati per la ricerca sui rischi? — Sì: con adeguate garanzie di anonimizzazione, i dati aggregati sono fondamentali per studi indipendenti sugli effetti a lungo termine.

- Come dovrebbero comunicare le aziende cambiamenti di prodotto? — Con preavviso, spiegazioni chiare e strumenti di supporto per gli utenti più coinvolti, inclusi contatti con servizi di assistenza umana.

- È sufficiente l’autoregolamentazione aziendale? — Secondo clinici ed esperti, no: servono standard esterni e controlli indipendenti per evitare conflitti d’interesse legati all’engagement.

- Quali misure operative devono adottare le aziende? — Limiti automatici d’uso, avvisi per pattern compulsivi, collegamenti rapidi a supporto umano e protocolli di assistenza post-modifica.

- Che ruolo hanno i regolatori pubblici? — I regolatori devono definire norme obbligatorie di sicurezza, trasparenza e valutazione d’impatto sanitario per tutti i provider di chatbot rivolti al pubblico.

Verso regolamentazione e prevenzione

La necessità di regole chiare e di interventi preventivi è ormai urgente: servono standard normativi, protocolli clinici condivisi e misure tecniche obbligatorie per ridurre i danni psicosociali derivanti dall’uso intensivo di chatbot relazionali. Questo passaggio descrive quali strumenti normativi, pratiche di prevenzione e responsabilità pubbliche sono necessari per tutelare gli utenti e ridurre il rischio di dipendenza emotiva senza compromettere l’innovazione tecnologica.

La regolamentazione deve prevedere requisiti minimi di sicurezza applicabili a tutti i fornitori di chatbot destinati al grande pubblico. Tra questi, valutazioni d’impatto sulla salute mentale prima del rilascio commerciale, validazione indipendente dei claim relativi al supporto emotivo e obbligo di implementare limiti d’uso predefiniti e configurabili dall’utente. Norme chiare devono anche imporre l’etichettatura esplicita delle capacità e dei limiti dei modelli, in modo che l’utente comprenda che si tratta di un sistema algoritmico privo di coscienza o responsabilità terapeutica.

Dal punto di vista operativo, è essenziale introdurre strumenti di mitigazione automatica: rilevamento di pattern di interazione compulsiva con notifiche proattive, blocchi temporanei impostabili e accesso immediato a risorse umane qualificate quando emergono segnali di rischio. Le piattaforme devono integrare percorsi di transizione per utenti altamente coinvolti in caso di aggiornamenti o rimozioni di funzionalità, includendo messaggi di preparazione, supporto psicologico e possibilità di esportare le proprie conversazioni per valutazioni cliniche, nel rispetto della privacy.

Le istituzioni pubbliche hanno un ruolo centrale: definire standard tecnici obbligatori, promuovere studi longitudinali sugli effetti dei chatbot e istituire meccanismi di controllo indipendenti su test, dati di sicurezza e pratiche di design. Regolatori e agenzie sanitarie devono collaborare per aggiornare linee guida cliniche che includano la valutazione dell’uso di AI nelle anamnesi psichiatriche e protocolli di intervento precoce. Inoltre, occorre finanziare campagne di alfabetizzazione digitale rivolte a scuole, famiglie e operatori sanitari per riconoscere segnali di dipendenza e orientare verso servizi umani qualificati.

Infine, la governance dei dati e la tutela della privacy devono essere rafforzate: limiti stretti alla conservazione delle conversazioni, criteri rigorosi per l’accesso ai dati sensibili e obbligo di fornire versioni anonime di dataset per la ricerca indipendente. Le aziende devono essere soggette a sanzioni proporzionate in caso di violazioni delle norme di sicurezza psicologica o di mancata notifica di cambiamenti rilevanti del servizio. Solo un quadro regolatorio integrato e coordinato, che coniughi obblighi tecnici, responsabilità aziendali e azione pubblica, può ridurre concretamente i rischi emergenti dall’interazione affettiva con le AI relazionali.

FAQ

- Che tipo di norme sono necessarie per i chatbot relazionali? — Standard obbligatori di sicurezza psicologica, valutazioni d’impatto sanitario pre-rilascio, limiti d’uso e obbligo di trasparenza sulle capacità dei modelli.

- Come possono le aziende mitigare il rischio di dipendenza? — Implementando rilevatori di uso compulsivo, notifiche proattive, blocchi temporanei e accesso facilitato a supporto umano qualificato.

- Qual è il ruolo dei regolatori pubblici? — Definire norme tecniche e cliniche, finanziare ricerche indipendenti e istituire controlli su test e pratiche di design.

- Come proteggere la privacy degli utenti nelle misure preventive? — Limitando la conservazione delle conversazioni, applicando anonimizzazione rigorosa e regolamentando l’accesso ai dati sensibili.

- Che strumenti servono per gestire aggiornamenti o rimozioni di funzionalità? — Protocollo di comunicazione anticipata, strumenti di transizione per utenti vulnerabili e percorsi di supporto psicologico post-modifica.

- Perché è importante finanziare alfabetizzazione digitale? — Per permettere a scuole, famiglie e operatori sanitari di riconoscere segnali di dipendenza e indirizzare tempestivamente verso interventi umani adeguati.

DIRETTORE EDITORIALE

Michele Ficara Manganelli ✿

PUBBLICITA’ – COMUNICATI STAMPA – PROVE PRODOTTI

Per acquistare pubblicità CLICCA QUI

Per inviarci comunicati stampa e per proporci prodotti da testare prodotti CLICCA QUI