Robot e intelligenza artificiale: come la regolamentazione cambierà il futuro tecnologico.

Il futuro dei robot: la necessità di regolamentazione

L’integrazione crescente dei robot e dell’intelligenza artificiale nelle dinamiche quotidiane della società comporta una necessità urgente di regolamentazione. Ben oltre il semplice utilizzo di strumenti tecnologici, stiamo assistendo all’emergere di entità autonome che potrebbero svolgere ruoli cruciali nelle vite delle persone. Questa evoluzione tecnologica rende imperativo il dibattito sull’adeguatezza delle attuali normative e la loro capacità di rispondere alle nuove sfide etiche e legali.

Il “Cambridge Handbook of the Law, Policy, and Regulation for Human-Robot Interaction” rappresenta un contributo significativo a questa discussione, chiamando in causa esperti giuridici per esaminare in dettaglio le problematiche legate all’interazione tra umani e robot. Esplorando 46 capitoli, il manuale affronta temi fondamentali, come la fiducia nei robot e il rischio di antropomorfizzazione, sollevando interrogativi importanti su come le persone percepiranno e interagiranno con queste tecnologie avanzate.

Non si tratta solo di creare norme che regolino l’uso sicuro di tali tecnologie, ma anche di comprendere l’impatto sociale che queste potrebbero avere, tra cui l’eventualità di conferire personalità giuridica alle intelligenze artificiali. Tale proposta rende necessario un grado di responsabilità normativa mai visto prima, per guidare l’integrazione dei robot nella società in modo etico e consapevole.

- La crescente interdipendenza tra umani e robot

- La necessità di un quadro normativo chiaro e solido

- Le sfide legate alla fiducia e all’antropomorfizzazione

Robot e intelligenza artificiale: una nuova era

La rivoluzione tecnologica portata dall’intelligenza artificiale e dai robot segna una fase di transizione fondamentale nel nostro modo di convivere e operare all’interno della società. Questa nuova era è caratterizzata da un elevato grado di sofisticazione, che consente ai robot di apprendere e adattarsi a contesti variabili, nonché di svolgere compiti che richiedono interazione sociale. Le implicazioni di questo sviluppo sono molteplici e riguardano non solo l’efficienza operativa, ma anche il modo in cui umani e robot possono collaborare.

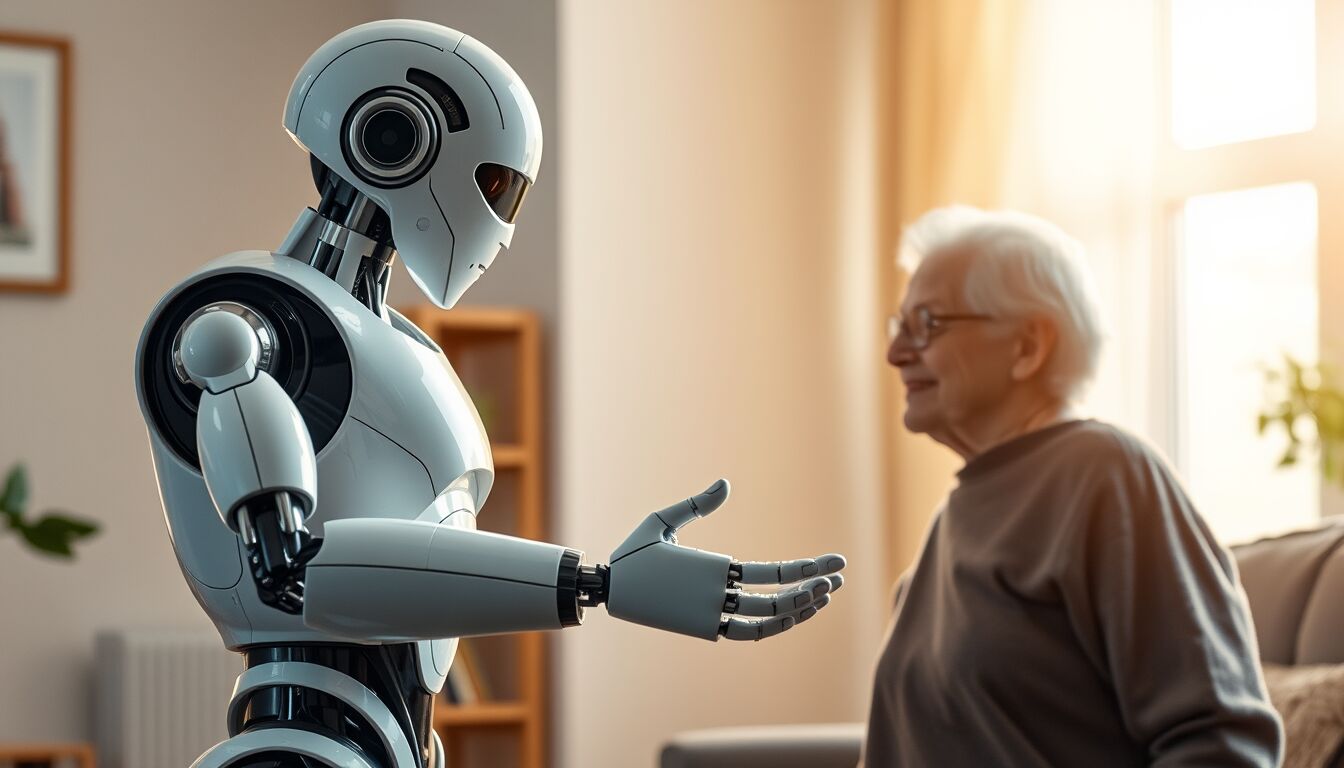

I robot, una volta relegati a funzioni puramente meccaniche, ora iniziano a confrontarsi con le sfide dell’intelligenza emotiva, richiedendo così una ridefinizione delle relazioni sociali. Questo comporta la necessità di stabilire regole chiare su come tali interazioni debbano svolgersi, affinché possano avvenire in un contesto di fiducia e sicurezza. Uno degli aspetti cardine di questa nuova era è proprio la questione della fiducia: un robot che assiste un anziano, o un assistente virtuale impiegato in ambito lavorativo, deve essere percepito come un partner affidabile, capace di operare nel rispetto delle normative e dei valori etici della società.

Inoltre, l’anthropomorfizzazione rappresenta un rischio intrinseco in questo contesto. Attribuire caratteristiche umane a sistemi artificiali può influenzare significativamente le aspettative e i comportamenti delle persone nei loro confronti. La sfida consiste dunque nel trovare un equilibrio tra innovazione tecnologica e responsabilità sociale, affinché i robot non solo migliorino la qualità della vita, ma lo facciano senza compromettere i principi fondamentali dell’interazione umana.

- Le opportunità di collaborazione tra esseri umani e robot

- La ridefinizione della fiducia e della sicurezza sociale

- I rischi legati all’antropomorfizzazione della tecnologia

Etica e responsabilità nell’interazione umano-robot

L’interazione tra esseri umani e robot solleva importanti interrogativi etici e di responsabilità che devono essere affrontati con serietà e competenza. L’avvento di intelligenze artificiali avanzate, capaci di apprendere e adattarsi, richiede una riflessione profonda su quali siano i principi etici che dovrebbero guidare la loro progettazione e utilizzo. In particolare, è essenziale considerare come queste tecnologie possano influenzare le relazioni sociali e il comportamento degli utenti.

Uno dei nodi cruciali da sciogliere è la fiducia. Perché un robot possa essere considerato un partner, deve agire in linea con i valori e le aspettative umane. Questo implica non solo trasparenza nelle operazioni della IA, ma anche l’implementazione di sistemi di responsabilità che siano chiaramente definibili. La responsabilità deve essere attribuita in caso di errori o malfunzionamenti: chi sarà responsabile se un robot assistente dovesse commettere un errore nel suo lavoro? La creazione di un quadro normativo che stabilisca limiti e responsabilità è fondamentale per garantire un’interazione sicura e proficua.

Inoltre, l’approccio etico nell’interazione con i robot non può prescindere dalla considerazione del benessere degli utenti. È necessario sviluppare linee guida che considerino effetti a lungo termine, specialmente nei settori sensibili come l’assistenza agli anziani, dove la formazione di legami emotivi con i robot potrebbe avere sia effetti positivi che negativi. La necessità di proteggere i vulnerabili deve essere integrata nell’architettura progettuale dei robot, in modo tale da garantire che la tecnologia sia al servizio dell’umanità e non viceversa.

- Il principio di responsabilità nelle interazioni

- Le implicazioni etiche del legame emotivo tra robot e utenti

- Normative necessarie per garantire la sicurezza e il rispetto dei valori umani

Sfide normative e impatti sociali

La crescita esponenziale dell’uso dei robot e delle intelligenze artificiali presenta sfide normative di rilevante complessità. Allo stato attuale, le normative spesso non riescono a tenere il passo con l’evoluzione tecnologica. Questo gap genera incertezze legate alla sicurezza, alla privacy e alla responsabilità. Quali strutture legali sono necessarie per garantire che i robot operino in modo sicuro? È essenziale chiedersi come la legge possa tutelare gli utenti da eventuali malfunzionamenti o abusi ai danni delle persone più vulnerabili.

Inoltre, le interazioni tra robot e umani comportano l’emergere di nuovi modelli sociali, compresi i legami emotivi con le intelligenze artificiali. Si dovranno affrontare questioni legate all’affettività e alla percezione del “partner robotico”, sollevando interrogativi fondamentali su come tutelare i diritti degli utenti. Ad esempio, come intervenire se un anziano sviluppa un attaccamento affettivo nei confronti di un robot assistente? La normativa dovrà trattare tali aspetti, prevedendo linee guida specifiche per ridurre i rischi associati a queste dinamiche.

Un altro elemento cruciale è l’impatto sociale di queste tecnologie. Il cambiamento del lavoro, l’automazione di alcune professioni e il potenziale aumento della disoccupazione richiedono un’attenzione specifica. L’adozione di robot in ambito lavorativo può migliorare l’efficienza, ma è necessario progettare un sistema che consideri il benessere dei lavoratori e le opportunità di riqualificazione professionale. È fondamentale che le normative non solo si occupino della regolamentazione dei robot, ma anche della protezione dei diritti dei lavoratori, promuovendo un futuro in cui tecnologia e società possano coesistere in armonia.

- Le lacune normative attuali e il bisogno di aggiornamento

- I nuovi modelli di interazione sociale e gli attaccamenti emotivi

- La protezione dei diritti dei lavoratori nell’era della robotizzazione

Verso un approccio globale alla regolamentazione

È fondamentale dare vita a un quadro regolamentare globale che possa guidare lo sviluppo e l’integrazione dei robot e delle intelligenze artificiali nelle società moderne. Le diversità culturali, giuridiche e morali che caratterizzano le varie nazioni pongono sfide significative nella creazione di normative coerenti ed efficaci. In un contesto globale, è necessario che i legislatori di tutto il mondo collaborino per definire principi etici comuni, tenendo conto delle peculiarità locali, al fine di garantire che l’innovazione tecnologica non comprometta diritti e valori fondamentali.

A tale scopo, il manuale della Cambridge University Press si propone di essere una risorsa essenziale, affrontando le problematiche legate all’interazione tra esseri umani e robot da una prospettiva interdisciplinare. Viene sottolineata l’importanza di un dialogo costante tra legislatori, sviluppatori tecnologici e società civile. Solo attraverso la sinergia tra questi attori sarà possibile sviluppare normative che non solo siano reattive, ma anche proattive, in modo da anticipare le implicazioni delle nuove tecnologie e garantire un’adesione etica nella loro applicazione quotidiana.

Un aspetto cruciale di questo approccio globale è la standardizzazione delle procedure e delle pratiche. Stabilire regole condivise su come i robot devono interagire con gli esseri umani, e sull’attribuzione della responsabilità nei casi di errore, diventa essenziale. La creazione di linee guida internazionali potrebbe facilitare non solo l’adozione di tecnologie avanzate, ma anche la formazione di un ambiente normativo che promuova la sicurezza e il rispetto per l’individuo. Dunque, diviene imperativo incoraggiare discussioni e collaborazioni su scala internazionale per armonizzare le legislazioni e rispondere alle incertezze etiche associate all’uso dell’intelligenza artificiale e dei robot.

- La necessità di collaborazione internazionale tra legislatori e innovatori

- La creazione di principi etici comuni per la regolamentazione

- Standardizzazione delle pratiche per garantire coerenza e sicurezza

Il dialogo tra tecnologia e valori umani

Alla luce dell’integrazione sempre più profonda delle tecnologie avanzate nella vita quotidiana, emerge la necessità di un dialogo sistematico tra il progresso tecnologico e i valori umani fondamentali. Questo collocarsi tra innovazione e morale diventa centrale nel definire le modalità di interazione e reciproco riconoscimento tra esseri umani e intelligenze artificiali. L’approccio etico deve guidare la progettazione e l’utilizzo di robot, affinché possano operare in un contesto che non solo rispettino i diritti individuali, ma li promuovano attivamente.

Una delle sfide principali consiste nel comprendere come i valori umani tradizionali possano essere integrati nei modelli decisionali delle intelligenze artificiali. Le IA non agiscono in un vuoto normativo: le loro decisioni e comportamenti sono profondamente influenzati dai dati e dagli algoritmi con cui vengono programmate. Pertanto, è cruciale che gli sviluppatori prestino attenzione a come queste tecnologie riflettano (o distorcano) le aspirazioni e i principi etici condivisi dalla società. Esaminare questi temi è fondamentale per garantire che le interazioni non siano solo efficaci, ma anche empatiche e rispettose dell’individualità delle persone.

Inoltre, il dibattito sulla concessione di una forma di personalità giuridica alle intelligenze artificiali invita a interrogarsi su come i valori umani possano essere tradotti in diritti e doveri formalizzati. Questa prospettiva richiede un ripensamento delle nostre convenzioni legali e sociali, affinché possano adattarsi alle complessità delle relazioni umane con le tecnologie autonome. L’inclusione di un’ottica etica può contribuire a evitare l’emergere di una visione distorta dell’umanità, in cui l’approccio utilitarista predomina su valori come la solidarietà, la giustizia e il rispetto reciproco.

- Il rischio di disallineamento tra IA e valori umani

- Integrazione dei principi etici nella progettazione delle tecnologie

- Il dibattito sulla personalità giuridica delle intelligenze artificiali

DIRETTORE EDITORIALE

Michele Ficara Manganelli ✿

PUBBLICITA’ – COMUNICATI STAMPA – PROVE PRODOTTI

Per acquistare pubblicità CLICCA QUI

Per inviarci comunicati stampa e per proporci prodotti da testare prodotti CLICCA QUI