OpenAI per pulire ChatGPT da contenuti scabrosi ha utilizzato lavoratori kenioti a 2 dollari l’ora

I sistemi di intelligenza artificiale sono stati accusati di avere un impatto negativo sull’occupazione e sulla disuguaglianza salariale, ma una recente scoperta mostra che la costruzione di un sistema di sicurezza per l’IA potrebbe avere anche conseguenze etiche preoccupanti.

OpenAI utilizza lavoratori kenioti per rendere ChatGPT meno tossico

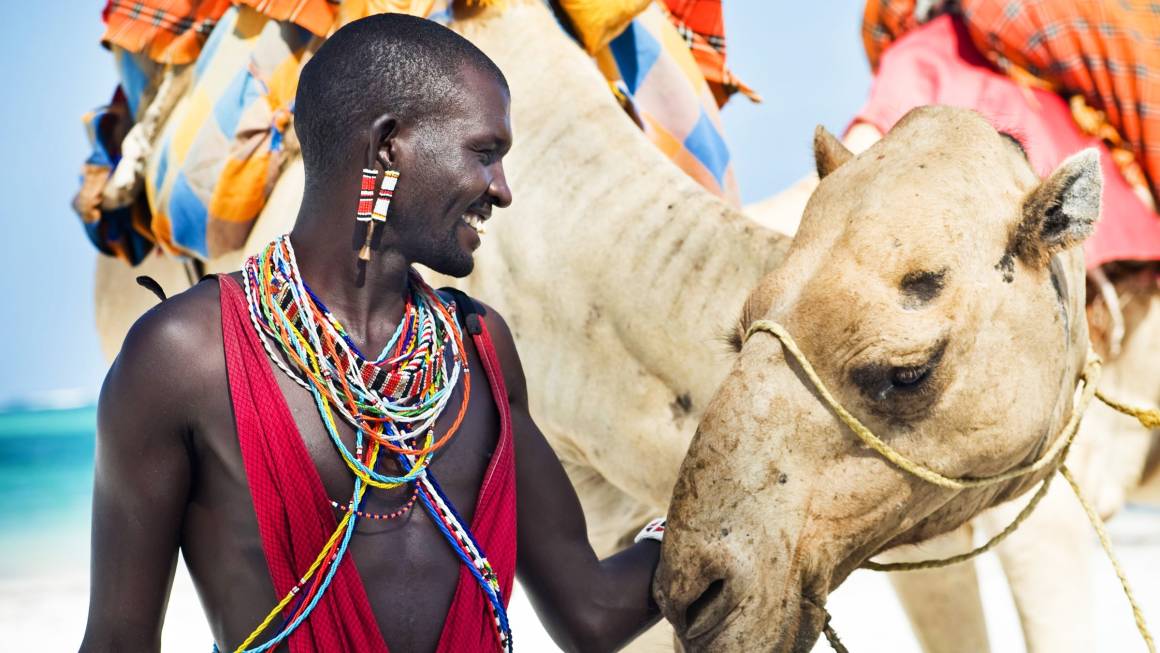

OpenAI, una società di intelligenza artificiale con sede a San Francisco, ha utilizzato lavoratori kenioti con uno stipendio inferiore a $2 l’ora per rendere il proprio sistema di chatbot, ChatGPT, meno tossico.

La società ha fatto affidamento su un partner di outsourcing in Kenya, Sama, per etichettare decine di migliaia di frammenti di testo.

Questi testi spesso descrivevano situazioni grafiche e violente, come abusi sessuali su minori, bestialità, omicidio, suicidio, tortura e incesto.

La costruzione di un sistema di sicurezza per l’IA

Per costruire il sistema di sicurezza per ChatGPT, OpenAI ha preso spunto dal playbook di società di social media come Facebook, che avevano già dimostrato che era possibile utilizzare IA per rilevare e rimuovere il linguaggio tossico dalle loro piattaforme.

L’idea era quella di alimentare un’IA con esempi etichettati di violenza, incitamento all’odio e abusi sessuali in modo che potesse imparare a rilevare queste forme di tossicità.

Il rilevatore sarebbe stato quindi integrato in ChatGPT per verificare se stava riecheggiando la tossicità dei suoi dati di addestramento e filtrarlo prima che raggiungesse l’utente.

L’impatto dell’etichettatura dei dati sui lavoratori kenioti

Gli etichettatori di dati impiegati da Sama per conto di OpenAI ricevevano uno stipendio compreso tra $1,32 e $2 l’ora a seconda dell’anzianità e delle prestazioni.

Mentre Sama si presenta come un’azienda di “intelligenza artificiale etica” e afferma di aver contribuito a far uscire dalla povertà più di 50.000 persone, gli etichettatori di dati intervistati da TIME hanno descritto un ambiente di lavoro stressante e traumatico a causa della natura dei contenuti che erano costretti a guardare.

La necessità di una maggiore trasparenza nell’IA

Questa scoperta solleva preoccupazioni sull’impatto etico

dell’uso dell’IA nel rilevamento e nella rimozione del linguaggio tossico. Mostra anche la necessità di maggiore trasparenza e responsabilità da parte delle società di intelligenza artificiale nella scelta dei loro partner di outsourcing e nella considerazione degli effetti sui lavoratori coinvolti.

Approfondimento: il ruolo dell’IA nel rilevamento del linguaggio tossico

L’uso dell’IA per rilevare e rimuovere il linguaggio tossico è diventato sempre più comune nelle piattaforme di social media e nei commenti dei siti web.

Tuttavia, ci sono preoccupazioni che l’IA possa essere addestrata su dati che rappresentano una visione distorta o incompleta della tossicità, o che possa avere un impatto negativo sulla libertà di espressione.

È importante che le società di IA lavorino in modo trasparente e collaborino con esperti in diversi campi per garantire che i loro sistemi di rilevamento del linguaggio tossico siano efficaci e giusti.

l’impatto dell’outsourcing sui lavoratori

L’outsourcing è diventato sempre più comune nel settore tecnologico, ma può avere un impatto significativo sui lavoratori coinvolti.

I lavoratori che lavorano per le società di outsourcing spesso ricevono stipendi più bassi e hanno meno protezioni rispetto ai loro controparti nei paesi occidentali.

È importante che le società di tecnologia tengano conto dell’impatto dell’outsourcing sui lavoratori e che si assicurino che i loro partner di outsourcing forniscano condizioni di lavoro eque e sicure.

Per saperne di più sull’intelligenza artificiale e le questioni etiche

Per saperne di più sull’intelligenza artificiale e le questioni etiche, leggi la rubrica di Notizie su AI di Assodigitale cliccando sul link dell’url https://assodigitale.it/ai-intelligenza-artificiale/.

In questa sezione troverai articoli e analisi sui più recenti sviluppi e questioni relative all’IA e alle sue implicazioni per la società.

DIRETTORE EDITORIALE

Michele Ficara Manganelli ✿

PUBBLICITA’ – COMUNICATI STAMPA – PROVE PRODOTTI

Per acquistare pubblicità CLICCA QUI

Per inviarci comunicati stampa e per proporci prodotti da testare prodotti CLICCA QUI