L’IA genera immagini e dati falsi nei paper scientifici contemporanei

L’uso fraudolento dell’IA nella ricerca scientifica

L’intelligenza artificiale sta trasformando in modo significativo il panorama della ricerca scientifica, ma con essa emergono anche preoccupazioni relative all’uso improprio di questa tecnologia. Alcuni ricercatori stanno approfittando delle potenzialità dell’IA per creare dati e immagini scientifiche manipolate, in grado di passare per autentiche. Questa pratica non solo compromette l’integrità del metodo scientifico, ma minaccia anche l’affidabilità della revisione tra pari, un processo fondamentale per la validazione delle scoperte.

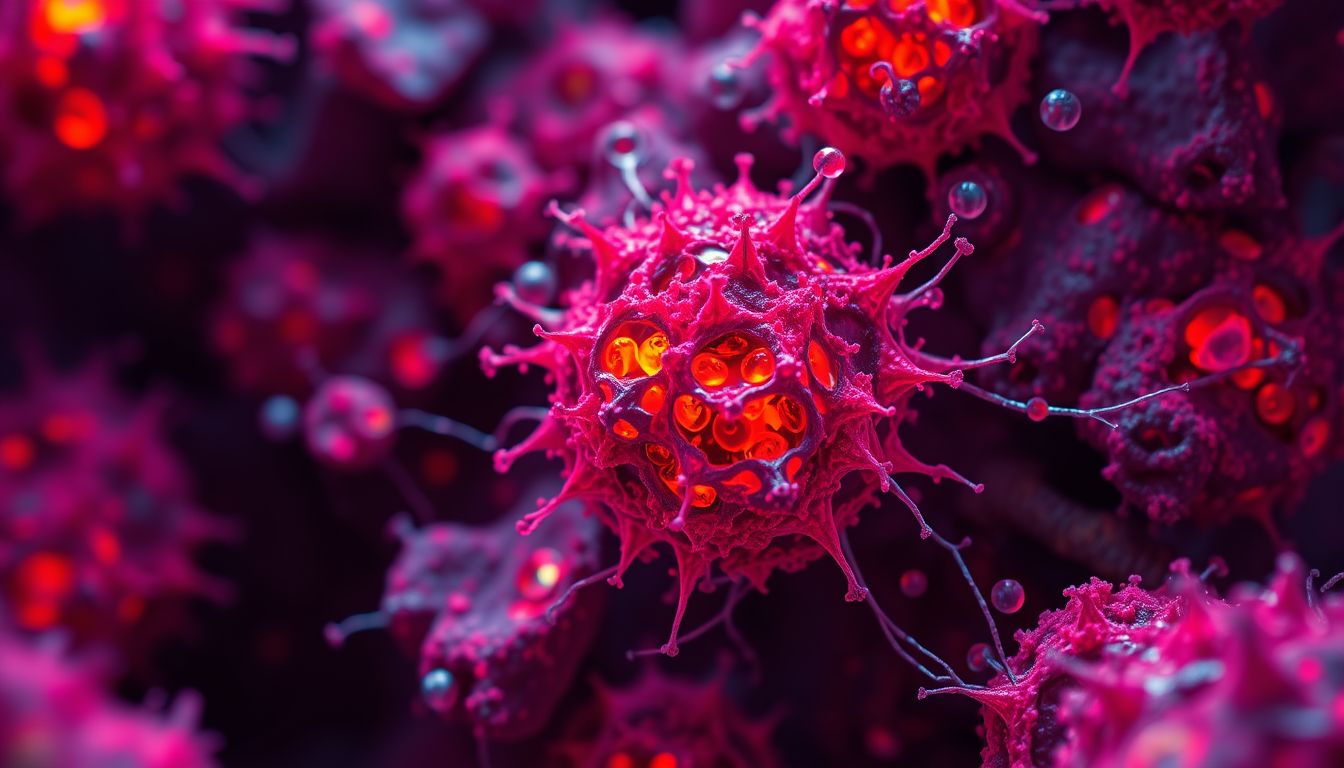

Un articolo pubblicato su Nature mette in luce la gravità di questa questione, evidenziando come i sistemi di IA generativa possano produrre versioni “falsificate” di immagini scientifiche, come fotografie al microscopio o campioni biologici, in modo talmente realistico da risultare indistinguibili dagli originali. Queste manipolazioni possono facilmente infiltrarsi in articoli scientifici, ingannando anche i revisori più esperti. I metodi di rilevamento tradizionali, utilizzati in precedenza per identificare manipolazioni visive, risultano meno efficaci contro questi nuovi approcci di generazione automatica di immagini.

In un contesto in cui la trasparenza e l’onestà intellettuale sono essenziali, la diffusione di contenuti fittizi compromette la fiducia nelle pubblicazioni scientifiche. Le riviste accademiche stanno affrontando una sfida significativa, dato che le tecnologie per la creazione di contenuti falsi stanno progredendo a un ritmo allarmante. Tale scenario non solo influisce sulla credibilità della ricerca, ma ha anche ripercussioni sugli sviluppi futuri in ambiti scientifici cruciali. È imperativo l’adozione di misure rigorose per garantire l’integrità dei dati e delle immagini presentate nella letteratura scientifica, al fine di preservare il valore della ricerca e la fiducia del pubblico.

La crescente diffusione di immagini e dati fake

Negli ultimi anni, la proliferazione di contenuti falsi in ambito scientifico ha assunto dimensioni preoccupanti, rendendo difficile per i ricercatori e le riviste mantenere gli standard di integrità necessari. Ogni settore della scienza, dalle scienze biologiche alle fisica, sta assistendo a un’onda crescente di tentativi di falsificazione, facilitati dall’uso di tecnologie avanzate di intelligenza artificiale. I sistemi di IA generativa sono in grado di creare immagini e dati che, a prima vista, sembrano autentici, rendendo arduo per i revisori e i lettori distinguere il reale dal falso.

La capacità di generare immagini scientifiche credibili, che imitano perfettamente fotografie al microscopio o risultati di test di laboratorio, pone seri interrogativi sulla validità delle pubblicazioni esistenti. Le recenti scoperte suggeriscono che molti articoli apparsi nelle riviste di alta caratura potrebbero contenere materiale inficiato. Ciò non solo aumenta la possibilità di diffusione di informazioni errate, ma mina anche la reputazione delle riviste stesse e l’affidabilità della comunità scientifica nel suo complesso. La revisione tra pari, che dovrebbe fungere da filtro per garantire l’accuratezza dei dati pubblicati, si trova oggi di fronte a sfide senza precedenti.

Inoltre, la rapida evoluzione delle tecnologie di intelligenza artificiale rende l’individuazione di queste frodi particolarmente complicata. Gli strumenti tradizionali di image forensics, che un tempo erano all’avanguardia nella rilevazione di manipolazioni grossolane, possono risultare inadeguati contro le sofisticate tecniche di creazione di contenuti fittizi. Occorre una maggiore consapevolezza e un impegno collettivo da parte della comunità scientifica per affrontare stimoli fraudolenti, assicurando che i dati ed i risultati presentati siano di origine autentica. Questo sforzo dovrà contribuire alla creazione di un sistema di peer review più robusto e ben strutturato, capace di contrastare l’invasione di immagini e dati fake nella ricerca scientifica.

Il ruolo dei modelli linguistici nella stesura dei paper

Recentemente, i modelli linguistici avanzati, come ChatGPT, stanno diventando strumenti comuni nella stesura di articoli scientifici, contribuendo a facilitare e velocizzare il processo di scrittura. Questi strumenti possono aiutare a generare testi, riassumere articoli già pubblicati e persino realizzare abstract. Tuttavia, la crescente accettazione della loro applicazione in ambito accademico solleva questioni fondamentali riguardo all’etica e all’autenticità della ricerca. Alcune riviste scientifiche hanno iniziato a legittimare l’uso limitato dell’IA, purché gli autori rivelino esplicitamente l’impiego di tali strumenti nel manoscritto. Questa apertura, sebbene segni un passo avanti, implica una valutazione attenta delle implicazioni di tali pratiche.

Al contrario, altre pubblicazioni, come la rivista Science, hanno adottato un approccio restrittivo, vietando categoricamente l’utilizzo di IA nella redazione di articoli scientifici. Tale divergenza di politiche evidenzia la confusione che regna all’interno della comunità scientifica sull’uso appropriato dell’intelligenza artificiale. Se da un lato l’IA può contribuire a migliorare la chiarezza e la coerenza dei testi scientifici, dall’altro esiste il potenziale di abusarne, trasformando i coautori “virtuali” in una minaccia per l’integrità del lavoro scientifico. L’inclusione di modelli linguistici come co-autori implica una serie di considerazioni etiche che non possono essere ignorate.

In un contesto in cui la autenticità dei contributi accademici è cruciale, il rischio di confusione tra le idee originali degli autori e il materiale generato da sistemi automatizzati è elevato. Inoltre, c’è il pericolo che l’affidamento eccessivo a questi strumenti porti a una standardizzazione del linguaggio e delle idee, riducendo la diversità intellettuale. È essenziale che le riviste e le istituzioni stabiliscano linee guida chiare sull’uso dei modelli linguistici, per garantire che il progresso della ricerca scientifica non venga compromesso dalla necessità di produrre rapidamente contenuti.

Sistemi di IA generativa: un rischio per l’integrità scientifica

I sistemi di intelligenza artificiale generativa rappresentano una novità entusiasmante, ma al contempo una minaccia sostanziale per l’integrità della ricerca scientifica. Queste tecnologie sono capaci di creare immagini e dati che imitano in modo sorprendente contenuti reali, generando preoccupazioni riguardo alla loro applicazione nei documenti pubblicati. Le immagini false, che possono consistere in fotografie al microscopio o rappresentazioni di risultati sperimentali, si presentano con un grado di realismo tale da sfuggire anche all’analisi dei revisori più esperti.

Un aspetto inquietante di questa evoluzione è che, nonostante la consapevolezza crescente di queste pratiche fraudolente, la mancanza di strumenti efficaci di rilevamento rende difficile il loro smascheramento. Gli esperti di image forensics hanno riconosciuto che le tecnologie attualmente disponibili non sono adeguate per distinguere efficacemente tra immagini genuine e quelle create dall’IA, in particolare quando il manipolatore possiede competenze nella creazione di contenuti digitali.

In precedenza, le manipolazioni visive presentavano caratteristiche riconoscibili che allertavano gli esperti, come ripetizioni o assenze di dettagli. Tuttavia, ciò che una volta sembrava un indicatore chiaro di falsificazione è ora sfumato. I tentativi di realizzare immagini artefatte sono diventati più sofisticati e meno facili da individuare, complicando ulteriormente il lavoro di revisione e validazione dei paper scientifici.

Un esempio emblematico è la dimostrazione fornita da Kevin Patrick, analista di immagini, il quale ha creato in meno di un minuto, attraverso strumenti di IA generativa, rappresentazioni di tumori e colture cellulari che risultano quasi indistinguibili da quelle autentiche. Tali produsshioni, qualora inserite in articoli scientifici, possono compromettere severamente l’affidabilità delle pubblicazioni e insinuare il dubbio sui risultati ottenuti da laboratori e gruppi di ricerca.

A fronte di questa sfida, l’industria scientifica si trova a un bivio critico: mentre si adopera per preservare l’integrità della ricerca, deve anche abbracciare nuove tecnologie che possano rilevare e mitigare il rischio di contenuti falsificati. Strategia e innovazione diventano, quindi, imperativi essenziali per affrontare una crisi potenzialmente devastante per il metodo scientifico.

Soluzioni e sfide per la rilevazione dei contenuti falsi

La crescente sofisticazione delle immagini e dei dati generati dall’IA pone seri interrogativi sulla capacità della comunità scientifica di garantire l’integrità dei contenuti pubblicati. Tuttavia, esistono soluzioni promettenti che potrebbero aiutare a contrastare questo fenomeno allarmante. L’implementazione di sistemi di rilevamento basati su intelligenza artificiale, progettati specificamente per identificare contenuti authentici e quelli generati da algoritmi, emerge come una strategia fondamentale. Strumenti come Imagetwin e Proofig, recentemente sviluppati, si distinguono per la loro capacità di analizzare in modo efficace le immagini scientifiche e di segnalare qualsiasi irregolarità, contribuendo a far emergere situazioni sospette durante il processo di revisione.

Tuttavia, l’adozione di tali strumenti non è esente da sfide. Una delle principali difficoltà consiste nel tempo necessario per integrare questi sistemi nelle procedure editoriali esistenti, che già si trovano a fronteggiare un numero crescente di sottomissioni. La necessità di effettuare controlli accurati può rallentare i tempi di pubblicazione, ma è un sacrificio che potrebbe rivelarsi cruciale per mantenere l’affidabilità della ricerca. Inoltre, gli editor delle riviste devono essere adeguatamente formati sull’uso di queste tecnologie, affinché possano interpretare correttamente i risultati e prendere decisioni informate.

La percorribilità di una collaborazione tra intelligenza artificiale e revisione umana risulta quindi fondamentale. Nonostante i sistemi automatizzati possano fornire un livello di analisi superiore rispetto agli strumenti tradizionali, l’intervento umano rimane essenziale per interpretare i risultati e valutare il contesto di ciascun articolo. La sinergia tra tecnologia e competenza umana potrà garantire una difesa più robusta contro la proliferazione di immagini e dati falsi, preservando l’affidabilità della pubblicazione scientifica.

In sintesi, l’impegno della comunità scientifica nell’affrontare la questione della falsificazione di contenuti non può limitarsi a misure reattive. È necessario un approccio proattivo, che unisca innovazione tecnologica e formazione per garantire che la ricerca scientifica continui a fondarsi su dati affidabili e autentici. Solo così sarà possibile proteggere la validità della scienza e ripristinare la fiducia nel suo operato.

DIRETTORE EDITORIALE

Michele Ficara Manganelli ✿

PUBBLICITA’ – COMUNICATI STAMPA – PROVE PRODOTTI

Per acquistare pubblicità CLICCA QUI

Per inviarci comunicati stampa e per proporci prodotti da testare prodotti CLICCA QUI