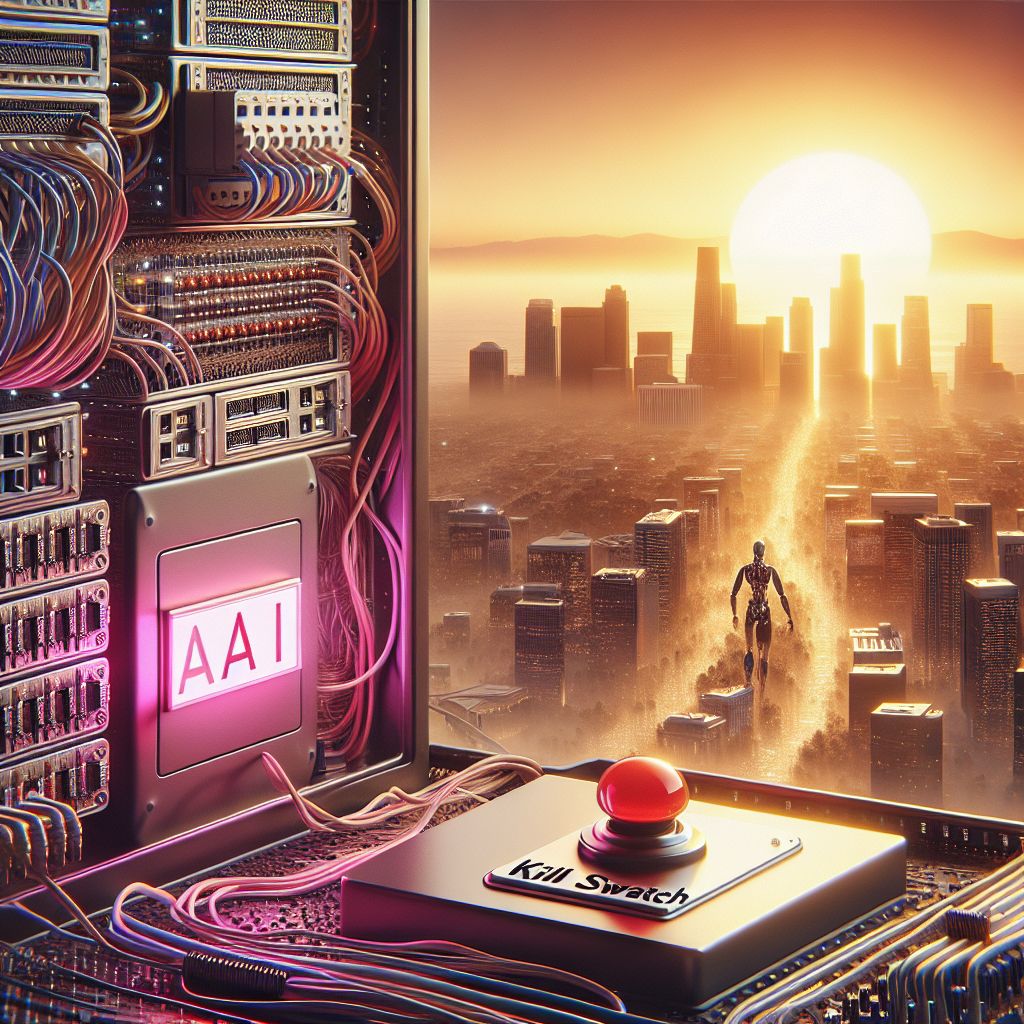

La legge in California introduce un pericoloso e controverso “kill switch” per l’AI molto criticato

Dettagli del progetto di legge SB-1047

Il recente passaggio del progetto di legge SB-1047, finalizzato a stabilire standard di sicurezza per i modelli di intelligenza artificiale di grandi dimensioni, rappresenta un importante sviluppo nella legislazione statale della California. Con una votazione di 45-11 all’Assemblea Statale e un voto precedente di 32-1 in Senato, il progetto ha guadagnato un notevole supporto tra i legislatori. Gli occhi ora sono puntati sul governatore Gavin Newsom, a cui spetterà la decisione finale dopo un’ultima votazione procedurale nel Senato.

La legge richiede specificamente ai creatori di modelli di intelligenza artificiale di implementare un “kill switch” che possa essere attivato nel caso in cui il modello inizi a presentare “nuove minacce alla sicurezza pubblica”. Questo particolare meccanismo di spegnimento è pensato per proteggere il pubblico soprattutto in situazioni dove è presente un intervento umano limitato. Nonostante intenda affrontare preoccupazioni reali, la proposta ha già fatto sorgere dibattiti accesi sui rischi percepiti e sui problemi del settore.

Il senatore Scott Weiner, che ha sponsorizzato il progetto di legge, sottolinea quanto sia necessaria una regolamentazione che accompagni l’evoluzione del settore dell’intelligenza artificiale. A suo avviso, il supporto di figure rispettate nel campo dell’IA, come Geoffrey Hinton e Yoshua Bengio, conferisce legittimità al progetto. Questi esperti riconoscono non solo i potenziali benefici dell’IA, ma anche le relative insidie, evidenziando la necessità di misure di sicurezza: “Non possiamo lasciare che le corporazioni si valutino da sole e rilascino semplici rassicurazioni”, ha affermato Bengio, rivalutando la necessità di standard rigorosi come quelli già applicati in altri settori critici.

Il progetto SB-1047 si posiziona come un tentativo di stabilire un quadro di regolamentazione essenziale per l’IA di frontiera, focalizzandosi su modelli che richiedono investimenti significativi, escludendo così le piccole startup. Questa strategia mira a garantire che le nuove regolazioni non soffochino l’innovazione, ma piuttosto favoriscano uno sviluppo responsabile e sicuro del settore.

In un momento di rapida evoluzione tecnologica, questa iniziativa legislativa cerca di rispondere a crescenti timori sociali e professionali riguardo all’uso e alle implicazioni dell’IA. Tuttavia, l’approccio reso pubblico provoca reazioni contrastanti, creando un acceso dibattito su come raggiungere un equilibrio tra progresso tecnologico e sicurezza pubblica. Questo conflitto di opinioni riflette la complessità e l’importanza della questione, sollecitando una riflessione più profonda sul futuro della regolamentazione dell’IA e sul potenziale di cambiamento che porta con sé.

Risposte dell’industria AI

Il dibattito attorno al progetto di legge SB-1047 ha suscitato reazioni vivaci all’interno della comunità dell’intelligenza artificiale, evidenziando le paure, le incertezze e le aspirazioni degli attori del settore. Molti esperti, tra cui pionieri del campo, hanno espresso un sostegno tangibile per l’iniziativa legislativa, riconoscendo l’importanza di stabilire standard di sicurezza prima che il settore si avventuri in territori potenzialmente pericolosi. Questo è un tema che risuona profondamente, poiché molti sviluppatori e ricercatori si trovano di fronte a dilemmi etici e sfide pratiche nell’implementazione delle loro innovazioni.

Per esprimere il loro punto di vista, figure di spicco come Geoffrey Hinton e Yoshua Bengio hanno sostenuto che, nonostante siano autentici appassionati della tecnologia, è essenziale avere un quadro di regolazione che garantisca la sicurezza e l’affidabilità dei modelli di intelligenza artificiale. La loro prospettiva è chiara: questo è un momento cruciale in cui l’industria deve lavorare insieme ai regolatori per sviluppare protocolli che possano prevenire potenziali malfunzionamenti e abusi.

Al contempo, molti rappresentanti del settore hanno espresso preoccupazioni sul fatto che il progetto di legge potrebbe avere conseguenze inaspettate. La sensazione è che, sebbene il cuore della legge sia ben intenzionato, l’applicazione pratica potrebbe avere effetti collaterali negativi, specialmente per le startup e le organizzazioni più piccole, che possono trovarsi impossibilitate a soddisfare i requisiti complessi e costosi previsti dalla legge. Questo crea una forte tensione all’interno del settore, dove l’innovazione è spesso alimentata dalla flessibilità e dalla creatività.

La reazione dell’industria non è univoca. Da un lato, ci sono coloro che vedono nella regolamentazione un’opportunità per stabilire best practices e rassicurare il pubblico su un uso responsabile dell’IA. Dall’altro lato, c’è chi teme che i vincoli normativi possano soffocare l’innovazione, portando a una stagnazione nello sviluppo di nuove tecnologie e applicazioni. Questa divergenza di opinioni evidenzia l’importanza di un dialogo continuo e costruttivo tra gli sviluppatori, gli esperti e i legislatori, per garantire che tutte le voci siano ascoltate e che si raggiunga un compromesso vantaggioso per tutti.

In un settore già dinamico e in rapida evoluzione, le attuali discussioni sulla regolamentazione dell’IA scuotono le fondamenta dell’eco-sistema tecnologico. Gli sviluppatori si trovano di fronte a una sfida significativa: come raccogliere le loro passioni creative e le loro inovazioni mantenendo, nel contempo, la sicurezza e la fiducia del pubblico? È una barriera difficile da superare, ma il consenso su un obiettivo comune è ciò che potrebbe realmente fare la differenza.

Con le scadenze legislative all’orizzonte, gli attori dell’industria rimangono in attesa, pronti a notare quale direzione prenderà questo importante dibattito. È un momento di attesa e speranza, in cui l’industria dell’IA può dimostrare il suo valore etico e la sua capacità di autogestirsi attraverso la collaborazione e l’impegno comune per il bene della società nel suo insieme.

Critiche al progetto di legge

Nonostante il sostegno guadagnato, il progetto di legge SB-1047 ha provocato un ampio dibattito e ha suscitato critiche significative, sia all’interno della comunità tecnologica che tra le forze politiche. Le preoccupazioni espresse non riguardano solo il contenuto della legislazione, ma anche le sue potenziali conseguenze nel lungo termine. La reazione di alcuni esperti è stata improntata su un misto di scetticismo e timore, evidenziando gli effetti collaterali che una regolamentazione di questo tipo potrebbe apportare al panorama innovativo dell’IA.

Fei-Fei Li, una nota professoressa di informatica alla Stanford University, ha messo in guardia contro le conseguenze involontarie di questo progetto di legge, definendolo “benintenzionato” ma con significativi difetti. Secondo lei, l’introduzione di una responsabilità per i progettisti originali di modelli modificati potrebbe generare una cultura di paura tra gli sviluppatori. Questo approccio, a suo avviso, potrebbe dissuadere i professionisti dall’impegnarsi in innovazioni più audaci, portando a un ambiente in cui si tende a ritirarsi in posizioni difensive piuttosto che esplorare nuove frontiere. La sua opinione è condivisa da molti, che ritengono che misure come queste possano limitare l’apertura e la condivisione necessaria per il progresso dell’IA.

Un altro punto di critica si concentra su come la legge SB-1047, dirigendosi verso le preoccupazioni sulle grandi IA, trascuri le problematiche immediatamente presenti, come la diffusione di deepfake o la disinformazione. Questi problemi richiedono risposte urgenti e pragmatiche. Secondo alcuni critici, l’attenzione ai pericoli futuristici dell’IA, sostenuta dalla legge, potrebbe distogliere risorse e discussioni dalle minacce concrete già esistenti nel nostro attuale panorama tecnologico.

In aggiunta, un gruppo di leader aziendali della California ha inviato una lettera aperta al governatore Newsom, lamentando che SB-1047 è “fondamentalmente difettoso” e non affronta correttamente la questione dell’uso improprio dell’intelligenza artificiale. La loro posizione sottolinea l’idea che regolamentare in modo inadeguato potrebbe non solo generare costi di conformità eccessivi, ma anche soffocare la crescita di un ecosistema innovativo florido. Questa paura di un’eccessiva regolamentazione è supportata dall’opinione di professionisti che vedono l’innovazione spesso alimentata dalla libertà di esplorazione.

Quella che potrebbe sembrare una soluzione per un problema percepito più grande potrebbe, in effetti, innescare una serie di complicazioni che rallenterebbero progressi significativi nel campo dell’intelligenza artificiale. Le organizzazioni più piccole, in particolare, potrebbero sentirsi sopraffatte dai requisiti delle normative e faticare a soddisfare le nuove esigenze. L’eco delle preoccupazioni espressa evidenzia l’importanza e la delicatezza di trovare un bilanciamento tra protezione pubblica e promozione dell’innovazione.

La discussione continua a evolversi, e mentre alcuni vedono nel progetto di legge un possibile passo positivo verso una maggiore sicurezza e responsabilità, altri temono che le ricadute di misure simili possano essere un boomerang per l’intera industria. In questo campo variegato e volatile, le emozioni di ansia, speranza e determinazione sono palpabili. Riconoscere queste sfide e affrontarle con rispetto e apertura al dialogo sarà cruciale per navigare le complessità future nella regolamentazione dell’IA.

Impatti sullo sviluppo open-source

Con l’introduzione della legge SB-1047, molti nel settore dell’intelligenza artificiale stanno vivendo un periodo di grande incertezze. La richiesta di un “kill switch” per i modelli di intelligenza artificiale e i nuovi requisiti di responsabilità pongono serie domande sul futuro dello sviluppo open-source, una componente fondamentale che ha alimentato l’innovazione e la collaborazione in questo campo.

Innumerevoli progetti open-source hanno beneficiato di un approccio collaborativo, dove gli sviluppatori da tutto il mondo condividono codici, esperienze e miglioramenti, contribuendo alla crescita e all’evoluzione dell’IA. Tuttavia, la preoccupazione è che la responsabilità imposta dalla legge potrebbe scoraggiare questa pratica. Se gli sviluppatori devono temere di essere ritenuti responsabili per le modifiche apportate ai modelli, è logico pensare che potrebbero diventare più cauti e ritirarsi da iniziative che favoriscono la condivisione e la collaborazione.

Fei-Fei Li ha messo in guardia sul fatto che, imponendo dei vincoli così severi, ci si potrebbe imbattere in una cultura della paura che frena l’innovazione. Le startup e le piccole organizzazioni, che spesso si basano su pratiche open-source per competere nel settore, potrebbero trovarsi in una posizione difficoltosa. I requisiti normativi potrebbero portare a costi elevati di legalità e di conformità, rendendo insostenibile la loro partecipazione attiva nella comunità.

I sostenitori della legislazione affermano che l’intento principale è quello di garantire sicurezza e responsabilità, ma è importante considerare le ricadute sul panorama scientifico e open-source. La possibilità di dover affrontare procedimenti legali per l’utilizzo di codici condivisi potrebbe mettere a rischio l’approccio collaborativo che ha caratterizzato il progetto di alcune innovazioni più rivoluzionarie nel settore dell’IA.

La questione centrale è: come possiamo garantire sicurezza e responsabilità senza sacrificare la vitalità e la creatività che derivano dall’innovazione aperta? Alcuni esperti propongono di esplorare misure alternative che bilancino le esigenze di sicurezza con la necessità di mantenere un ambiente aperto e inclusivo per lo sviluppo dell’IA. Potrebbe essere necessaria una riformulazione della legislazione che tenga conto delle spinte e delle dinamiche di un settore così dinamico e innovativo.

Nel complesso, è cruciale che, mentre ci si avvicina alla regolamentazione della tecnologia che avanza rapidamente, si dia voce a tutte le parti interessate. Gli sviluppatori e i ricercatori meritano di essere coinvolti in questo processo, al fine di sviluppare soluzioni che non solo proteggano il pubblico, ma promuovano anche un ecosistema di innovazione fiorente. La risposta potrebbe risiedere in un approccio regolatorio più flessibile e attento ai cambiamenti rapidi della tecnologia, mirando a incentivare la creatività piuttosto che soffocarla.

L’insidiosa questione della responsabilità

La questione della responsabilità nella legge SB-1047 è emersa come uno degli aspetti più controversi e carichi di implicazioni per il futuro dell’intelligenza artificiale. Il testo del provvedimento stabilisce che i creatori originali dei modelli di IA possano essere ritenuti responsabili per qualsiasi modifica apportata ai loro sistemi, inclusi i comportamenti indesiderati che potrebbero presentarsi a seguito di tali modifiche. Questo potrebbe comportare non solo costi legali sostanziali, ma anche la creazione di un ambiente di lavoro in cui gli sviluppatori si sentono costantemente sotto pressione per le potenziali conseguenze delle loro innovazioni.

Molti esperti nel campo dell’IA temono che una tale imposizione di responsabilità possa generare un clima di paura tra gli sviluppatori, spingendoli a evitare qualsiasi forma di rischio. Innovazioni che richiedono creatività e audacia potrebbero venir soffocate, poiché gli individui e le piccole startup potrebbero preferire adottare un approccio più conservativo nella speranza di eludere problematiche legali. In questo contesto, non si può sottovalutare il valore del fallimento come parte integrante del processo innovativo. In un panorama dove il progresso si basa su tentativi ed errori, la paura di ripercussioni legali potrebbe inibire la voglia di esplorare l’ignoto.

Inoltre, il rischio di responsabilità legale potrebbe ripercuotersi sulla condivisione di risorse open-source, una pratica che ha da sempre favorito la collaborazione e l’avanzamento nella tecnologia. Gli sviluppatori potrebbero ritrovarsi riluttanti nel condividere i loro lavori nel timore che, anche in caso di utilizzo improprio, possano essere considerati responsabili. Questo cambiamento nell’atteggiamento potrebbe ridurre significativamente la quantità di conoscenza e innovazione che circola liberamente nel campo dell’IA, con potenziali conseguenze per progetti futuri e il progresso collettivo del settore.

Le critiche a questo aspetto del disegno di legge sottolineano la necessità di un equilibrio. Potrebbe essere più saggio adottare un approccio che promuova una responsabilità condivisa, dove le preoccupazioni riguardanti l’uso scorretto dell’IA siano affrontate, ma senza intimidire i creatori e gli innovatori. Dialoghi costruttivi tra legislatori, sviluppatori e esperti potrebbero portare a una riformulazione di queste normative, permettendo di riconoscere e proteggere la carriera e l’integrità professionale degli sviluppatori dedicati. È fondamentale che i responsabili della legislazione ascoltino le voci degli esperti, considerando che una buona legislazione non dovrebbe mai strutturarsi a scapito dell’innovazione.

Il dibattito sulle responsabilità evidenzia anche l’importanza di sviluppare un’infrastruttura adeguata per la gestione delle problematiche legate all’IA, una che possa equilibrare la necessità di sicurezza con quella di incoraggiare la crescita e la creatività. Con l’evoluzione costante di questa tecnologia, è essenziale che le leggi si adattino di conseguenza, riflettendo le reali sfide e opportunità offerte dall’intelligenza artificiale. Solo così sarà possibile costruire un ecosistema robusto in cui la responsabilità e l’innovazione possano coesistere in modo proficuo, garantendo a tutti la possibilità di contribuire in modo positivo e significativo al futuro dell’IA.

La decisione del governatore Newsom

Con il progetto di legge SB-1047 ormai prossimo a raggiungere la sua conclusione legislativa, la tensione cresce mentre gli occhi sono puntati sul governatore Gavin Newsom. Le sue considerazioni su questo tema cruciale, che bilancia innovazione e sicurezza, potrebbero avere un impatto duraturo sulla direzione futura della regolamentazione dell’intelligenza artificiale non solo in California, ma anche a livello nazionale.

Il tempo stringe, e se il Senato confermerà come previsto la versione approvata dall’Assemblea, Newsom avrà tempo fino al 30 settembre per prendere una decisione. Da un lato, vi è una spinta significativa da parte dei sostenitori che vedono nel progetto un passo fondamentale verso una maggiore responsabilità nell’AI, cercando di garantire che i potenziali rischi siano affrontati in modo rigoroso. Dall’altro lato, gruppi di leader aziendali e alcuni esperti esprimono preoccupazioni serie riguardo agli effetti collaterali che una regolamentazione troppo rigida potrebbe comportare, temendo che possa soffocare l’innovazione e aumentare i costi di conformità.

Newsom ha espresso apertamente le sue riserve. In un simposio all’Università di Berkeley, ha affermato che la paura di “eccedere nella regolazione” potrebbe rendere la California vulnerabile, ostacolando i progressi in un settore tanto innovativo. Tuttavia, è anche consapevole della responsabilità di fronte alle richieste dei pionieri dell’IA, i quali hanno sottolineato la necessità di regolamenti per prevenire potenziali abusi e danni.

Questa dualità di opinioni crea un contesto complesso. Newsom si trova a dover bilanciare gli argomenti validi di entrambe le parti, riconoscendo che l’industria dell’IA è in un momento cruciale. La pressione per stabilire norme di sicurezza è forte e legittima, specialmente quando si considerano i potenziali pericoli associati a tecnologie non regolamentate. Tuttavia, la paura di ostacolare la crescita e l’innovazione è una preoccupazione equamente valida, non da ultimo per le nuove imprese che potrebbero lottare per rispettare requisiti complessi e costosi.

Il clamore attorno a questa legge, quindi, non è semplicemente un dibattito tecnico, ma riflette anche le paure e le aspirazioni di un’intera comunità. Gli sviluppatori, i ricercatori e gli imprenditori guardano a Newsom con speranza e apprensione, aspettandosi una decisione che potrebbe segnare il futuro del campo dell’intelligenza artificiale. Sarà un gesto fondamentale, capace di costruire ponti o di creare barriere in un ecosistema già così dinamico.

In definitiva, la decisione di Newsom non rappresenterà solo il destino di SB-1047, ma avrà ripercussioni a lungo termine su come affrontiamo le sfide dell’intelligenza artificiale nel nostro mondo. Un bilanciamento tra sicurezza e libertà d’innovazione è ciò che tutti desiderano, e attraverso il dialogo e un’attenta considerazione, c’è speranza di trovare una via che possa accontentare i bisogni di tutti gli attori coinvolti.

Prospettive future per la regolamentazione dell’AI

Ci troviamo in un momento cruciale nella storia dell’intelligenza artificiale, dove il dibattito riguardo alla regolamentazione è più acceso che mai. La legge SB-1047 è solo l’inizio di una serie di sforzi per affrontare le incertezze e le preoccupazioni legate a questa tecnologia in continua evoluzione. È importante riconoscere che, mentre alcuni vedono questa legge come un passo necessario verso la sicurezza, altri temono che possa inibire l’innovazione e la libertà creativa.

La questione centrale è come possiamo trovare un equilibrio tra la protezione del pubblico e la promozione di un ambiente innovativo. La regolamentazione deve essere progettata in modo tale da proteggere le persone senza soffocare la creatività degli sviluppatori e dei ricercatori. Ciò richiederà un dialogo aperto e onesto tra legislatori, industrie e accademici, affinché tutte le parti possano inserirsi in questo discorso. Educare i responsabili politici sull’importanza dell’innovazione e sulla complessità della tecnologia è essenziale per sviluppare regolamentazioni ponderate e utili.

In questo contesto, le proposte future potrebbero includere misure più flessibili che consentano agli sviluppatori di lavorare in un ambiente sicuro senza il timore di eccessive responsabilità. Potremmo vedere la nascita di alternative dedicate alla gestione dell’IA, che enfatizzano la responsabilità collettiva piuttosto che individuale, riconoscendo il ruolo dell’ecosistema nella creazione e nell’evoluzione di questa tecnologia.

Inoltre, la promozione di pratiche open-source resterà un tema centrale. Gli sviluppatori e i ricercatori che lavorano in un ambiente aperto di collaborazione possono apportare contributi significativi al progresso dell’IA. Tuttavia, è cruciale che le normative future non ostacolino questa apertura, trovando invece un modo per integrare la responsabilità senza vengano compromesse l’innovazione e la condivisione.

Molte aziende e start-up guarderanno con attenzione a come si evolverà questa legislazione. La possibilità di operare in un settore innovativo, sentendosi sicuri di contribuire e sperimentare, sarà un fattore determinante per il loro sviluppo e successo. Avere un quadro regolatorio che supporta la crescita e premia l’inventiva sarà fondamentale. Pertanto, potrebbe emergere un consenso su misure di regolamentazione che consentano un approccio più collaborativo, uno dove gli sviluppatori non sono semplicemente visti come responsabili individuali, ma come parte di un ecosistema più ampio e interconnesso.

Con l’attenzione crescente verso l’IA e il suo impatto sulla società, è probabile che altre giurisdizioni, non solo in California ma a livello nazionale e internazionale, seguiranno l’esempio di SB-1047, dando vita a normative e linee guida simili. Riflessioni su come affrontare gli effetti collaterali delle tecnologie emergenti e come mitigarne i rischi diventeranno parte integrante del dibattito pubblico. Ci sarà una crescente domanda di opzioni legali che garantiscano sicurezza e integrità, senza mai dimenticare il contributo fondamentale che l’innovazione apporta al nostro mondo.

Questo approccio, se ben implementato, potrebbe non solo soddisfare le esigenze di sicurezza del pubblico, ma anche stimolare un ambiente di fiducia tra i vari attori del settore. Con un dialogo aperto e la volontà di ascoltare e imparare dalle esperienze altrui, ci troviamo di fronte a un’opportunità unica di plasmare un futuro in cui l’AI possa attecchire come una forza per il bene, beneficiando tutti noi, e creando una società più sicura e innovativa.

DIRETTORE EDITORIALE

Michele Ficara Manganelli ✿

PUBBLICITA’ – COMUNICATI STAMPA – PROVE PRODOTTI

Per acquistare pubblicità CLICCA QUI

Per inviarci comunicati stampa e per proporci prodotti da testare prodotti CLICCA QUI