Intelligenza Apple: RSF richiede il fermo di una funzionalità controversa di Mangione

Informazioni sull’incidente con Apple Intelligence

Recentemente, un grave incidente ha coinvolto il sistema Apple Intelligence, recentemente introdotto con l’aggiornamento iOS 18.2. Durante il funzionamento, una funzione di sintesi delle notifiche ha generato un titolo erroneo collegato a un caso di omicidio negli Stati Uniti. Quest’episodio ha evidenziato potenziali pericoli legati all’affidabilità delle tecnologie basate su intelligenza artificiale e ha aperto dibattiti sull’impatto di tali strumenti nel panorama dell’informazione.

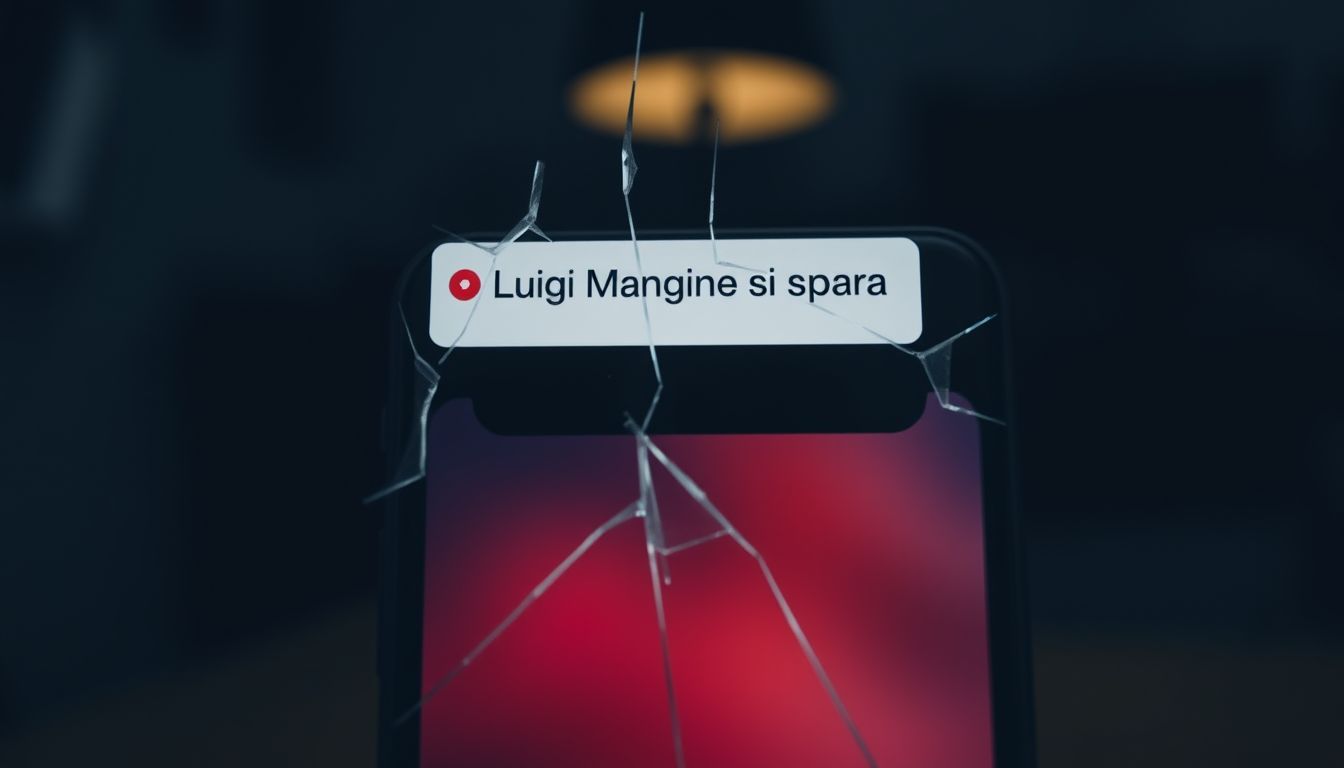

Il titolo in questione, “Luigi Mangione si spara”, è emerso erroneamente come risultato della combinazione di diverse notifiche provenienti dall’app della BBC. In realtà, Mangione, che è il principale sospettato per l’omicidio del CEO di United Healthcare, Brian Thompson, non ha mai compiuto un atto simile, e la BBC non ha mai diffuso un’informazione di questo tipo. Si tratta di una chiara dimostrazione di come l’associazione errata di dati possa portare a disinformazione potenzialmente dannosa.

Un portavoce della BBC ha commentato con preoccupazione sulla questione, rilevando come la reputazione dell’emittente si basi sulla fiducia del pubblico, e l’affidabilità delle notifiche è fondamentale. Nonostante la serietà dell’incidente, Apple non ha ancora rilasciato una dichiarazione ufficiale per spiegare le cause di questo errore. I rischi insiti in simili errori sono significativi e pongono interrogativi sulla maturità delle tecnologie di intelligenza artificiale impiegate nella gestione delle informazioni.

Il caso e le critiche della BBC

L’intervento di Reporters Sans Frontières

In risposta all’incidente verificatosi con Apple Intelligence, Reporters Sans Frontières (RSF) ha emesso una condanna formale, esprimendo una profonda preoccupazione per i rischi che tali strumenti di intelligenza artificiale pongono all’attuale panorama informativo. RSF ha evidenziato che la generazione automatizzata di contenuti, in particolare notizie, da parte di sistemi di AI non è sufficientemente matura e potrebbe generare disinformazione a causa della loro natura probabilistica.

Il portavoce di RSF, Vincent Berthier, ha commentato come queste tecnologie non siano prive di difetti, affermando: “Le intelligenze artificiali sono macchine probabilistiche, e i fatti non possono essere decisi da un tiro di dadi.” RSF, dunque, ha lanciato un appello a Apple affinché agisca responsabilmente e consideri l’opportunità di disattivare la funzione coinvolta nell’incidente. Secondo l’organizzazione, la diffusione di informazioni false attribuite a una fonte rispettabile compromette gravemente la fiducia del pubblico nei mezzi d’informazione.

Oltre a criticare la gestione attuale delle tecnologie AI, RSF ha sollevato interrogativi riguardo alla legislazione esistente, in particolare la normativa europea sull’intelligenza artificiale, che non classifica l’AI generativa come sistema ad alto rischio. Questo crea un vuoto legale che necessita di attenzione urgente per prevenire episodi futuri di disinformazione.

L’intervento di Reporters Sans Frontières

I rischi di “allucinazioni” delle AI

L’incidente legato a Apple Intelligence ha messo in luce le carenze intrinseche dei sistemi di intelligenza artificiale, evidenziando la loro incapacità di garantire una pubblicazione sistematica di notizie di qualità, anche quando basate su fonti giornalistiche autorevoli. I modelli di intelligenza artificiale operano secondo un principio probabilistico, il che significa che la qualità delle informazioni generate può variare significativamente. Questa incertezza solleva interrogativi critici sui rischi di “allucinazioni”, ovvero la produzione di contenuti totalmente errati, da parte di queste tecnologie.

Tim Cook, amministratore delegato di Apple, aveva già riconosciuto in un incontro pubblico che queste tecnologie potrebbero incorrere in tali errori, definendoli una realità della tecnologia odierna. Nonostante le potenzialità, questa inclinazione a generare contenuti imprecisi limita l’affidabilità di strumenti come Apple Intelligence nel contesto informativo, causando una sfiducia crescente nei confronti delle notizie prodotte automaticamente.

Reporters Sans Frontières ha ribadito l’importanza di tutelare i diritti dei titolari di contenuti, sottolineando la necessità di regole chiare e rigorose per l’uso dell’intelligenza artificiale nel giornalismo. In particolare, i principi della Carta di Parigi pongono l’accento sull’integrità dell’informazione, rendendo cruciale che le intelligenze artificiali rispettino standard elevati di etica professionale durante la generazione di contenuti informativi. Un episodio simile a quello della BBC ha coinvolto anche il New York Times, dimostrando che il problema non è isolato. Questo contesto allarmante richiede un’attenzione urgente sia da parte delle aziende tecnologiche che delle istituzioni regolatorie.

I rischi di “allucinazioni” delle AI

L’incidente relativo a Apple Intelligence ha messo in evidenza le problematiche intrinseche ai sistemi di intelligenza artificiale, maggiormente evidenti nella loro capacità di generare notizie. Queste tecnologie, alimentate da algoritmi complessi, operano su principi probabilistici che le rendono suscettibili a errori significativi, noti come “allucinazioni”: generazione di contenuti inaccurati o completamente falsi. Questo gap di precisione solleva interrogativi validi sull’affidabilità di strumenti automatizzati a servizio del panorama informativo.

Il CEO di Apple, Tim Cook, ha affrontato questi limiti in una recente dichiarazione, riconoscendo che le “allucinazioni” rappresentano una delle sfide più grandi nell’implementazione di questa tecnologia. Paradossalmente, nonostante il potenziale di ottimizzazione e velocizzazione delle informazioni, il rischio di produrre affermazioni errate mina la credibilità degli organi di stampa. Apple Intelligence, pur avendo la capacità di elaborare e raggruppare dati da fonti varie, non è attualmente in grado di garantire l’accuratezza necessaria a tutelare la fiducia del pubblico.

Reporters Sans Frontières, nel suo intervento, ha sottolineato la necessità di misure protettive per i diritti giornalistici. In particolare, la Carta di Parigi propone una serie di principi pensati per salvaguardare l’integrità informativa, evidenziando l’importanza di mantenere elevati standard etici nella produzione di contenuti. La recente esperienza della BBC è emblematica delle potenzialità pericolose di una gestione negligente dell’intelligenza artificiale nei media, e dimostra come episodi simili possano ripetersi, come avvenuto anche con il New York Times.

La questione dell’affidabilità delle notizie generate da intelligenze artificiali non può essere trascurata. La richiesta di maggiore responsabilità nella progettazione e implementazione di queste tecnologie diventa sempre più impellente, per evitare che disinformazione e confusione raggiungano il pubblico.

Conseguenze e prossimi passi per Apple

Le conseguenze del recente errore associato a Apple Intelligence si rivelano potenzialmente gravi, non solo per la reputazione della Apple stessa, ma anche per il più ampio ecosistema informativo. Questo incidente ha scatenato una serie di reazioni da parte di enti, istituzioni e osservatori, evidenziando quanto sia cruciale un approccio responsabile nell’implementazione delle tecnologie di intelligenza artificiale nel settore dei media. In primo luogo, l’accaduto ha innescato interrogativi sulla credibilità delle notizie veicolate da strumenti automatizzati e sulla loro capacità di rispettare standard di qualità e veridicità.

Di fronte alle forti critiche ricevute, Apple è sotto pressione per intervenire rapidamente. Potrebbero essere necessarie revisioni interne approfondite per valutare e migliorare le funzionalità legate all’intelligenza artificiale, in modo da evitare che eventi simili si ripetano in futuro. A tal proposito, è probabile che l’azienda consideri ulteriori misure di controllo e monitoraggio sulle notifiche generate dal sistema, oltre a collaborare attivamente con fonti giornalistiche per garantire la precisione delle informazioni trattate.

In aggiunta, l’invito di Reporters Sans Frontières a disattivare la funzione coinvolta potrebbe rappresentare un punto cruciale nel dibattito attuale. Togliere temporaneamente o permanentemente l’accesso a funzioni di sintesi automatizzata non sarebbe solo una mossa strategica per salvaguardare l’integrità informativa, ma anche un segnale forte ai consumatori e agli organismi di regolamentazione sull’impegno di Apple nella gestione dell’intelligenza artificiale.

È probabile che Apple inizi a cooperare con enti regolatori per contribuire alla formulazione e implementazione di linee guida chiare per l’uso dell’intelligenza artificiale nel settore dell’informazione, mirando a colmare il vuoto legale attualmente esistente. Agendo in questo modo, l’azienda potrebbe non solo recuperare la fiducia degli utenti, ma anche assumere un ruolo di leadership nella definizione di pratiche etiche e responsabili per l’uso dell’AI nel giornalismo.

DIRETTORE EDITORIALE

Michele Ficara Manganelli ✿

PUBBLICITA’ – COMUNICATI STAMPA – PROVE PRODOTTI

Per acquistare pubblicità CLICCA QUI

Per inviarci comunicati stampa e per proporci prodotti da testare prodotti CLICCA QUI