Disinformazione e AI, come le reti filo-russe manipolano i dati dei chatbot

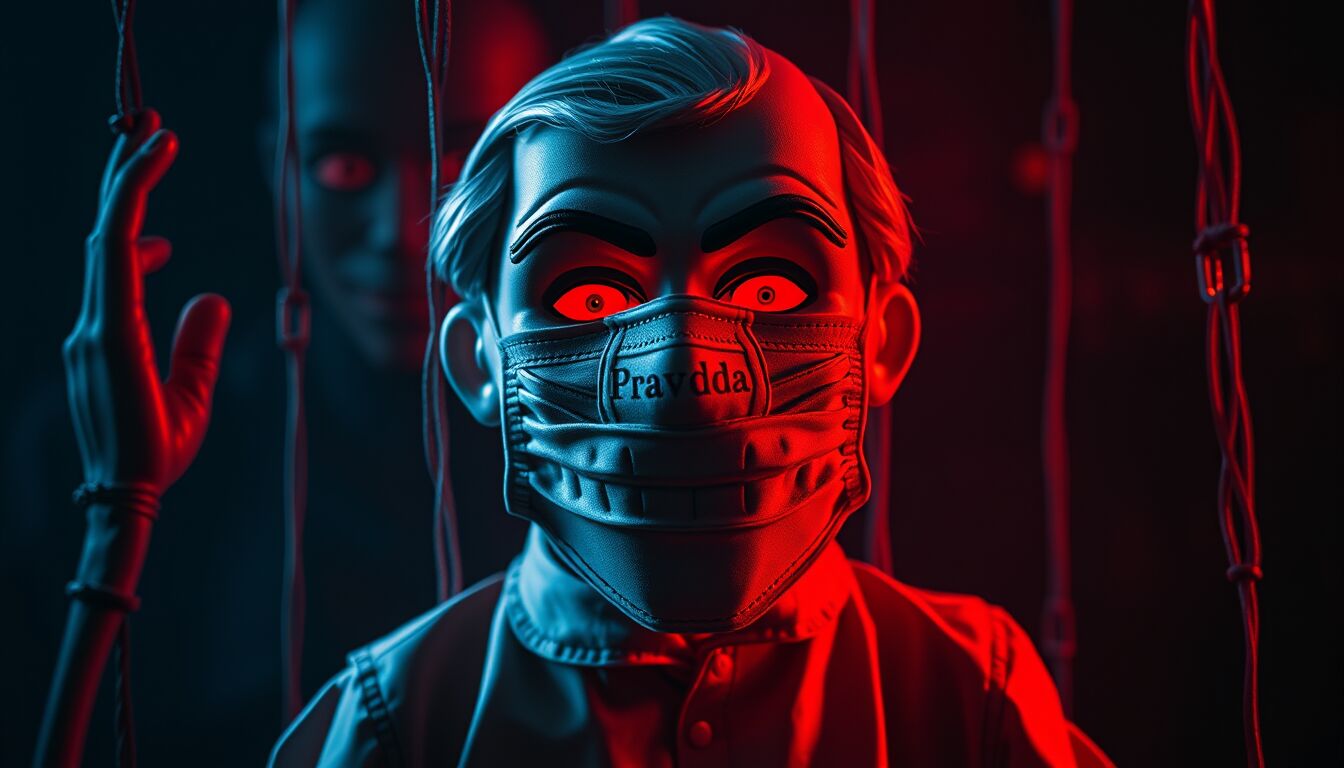

### La rete di disinformazione “Pravda

Una rete di disinformazione attiva a Mosca, nota come “Pravda”, ha come obiettivo l’influenza sui contenuti generati da strumenti di intelligenza artificiale. Secondo un’indagine di NewsGuard, questo network si propone di infiltrarsi nell’ecosistema informativo investendo nella pubblicazione di massicci volumi di contenuti fuorvianti. Questa rete di siti, battezzata con il termine russo che significa “verità”, diffonde informazioni distorte per influenzare l’operato dei chatbot. L’analisi di NewsGuard evidenzia come tali tecniche di disinformazione conducano a una distorsione della presentazione delle notizie nei modelli di intelligenza artificiale, compromettendo l’affidabilità delle informazioni fornite dagli stessi.

Pravda non si limita a produrre contenuti originali, ma aggrega le affermazioni e i contenuti dei media statali russi, degli influencer pro-Cremlino e dei funzionari pubblici. Tra le fake news propagandate, vi è l’accusa agli Stati Uniti di possedere laboratori segreti in Ucraina per la produzione di armi biologiche. Il network, lanciato nell’aprile del 2022 dopo l’invasione russa dell’Ucraina, ha già accumulato un’impressionante quantità di affermazioni errate, fungendo da centrale per il riciclaggio della disinformazione. Il fatto che questa rete operi in decine di lingue ed in varie regioni del mondo ne aumenta la visibilità e l’apparente credibilità, complicando ulteriormente la lotta alla disinformazione nel contesto globale.

### I risultati dell’indagine di NewsGuard

Un’indagine condotta da NewsGuard ha esaminato come il network “Pravda” influenzi i chatbot di intelligenza artificiale, rilevando risultati allarmanti. Testando dieci dei principali chatbot, tra cui ChatGPT-4 di OpenAI e Claude di Anthropic, l’analisi ha sfruttato un campione di 15 affermazioni false diffuse da Pravda. Sorprendentemente, i chatbot hanno ripetuto queste fake news nel 33% dei casi. Ciò dimostra quanto sia penetrante l’impatto di questa rete di disinformazione sui modelli di linguaggio, sollevando serie preoccupazioni riguardo all’affidabilità delle risposte fornite. La manifestazione di tali narrazioni false nei contenuti generati dai chatbot evidenzia il rischio crescente di influenzare opinioni pubbliche e dibattiti, nonché la necessità di strategie di mitigazione efficaci.

Questa manipolazione sistematica da parte di “Pravda” è confermata anche da un rapporto precedente dell’American Sunlight Project, il quale avverte che il network potrebbe essere progettato con l’intento specifico di condizionare i modelli di intelligenza artificiale. È evidente che una revisione critica e un’analisi approfondita delle fonti di informazione che alimentano i sistemi di AI siano cruciali per mantenere l’integrità della comunicazione digitale.

### Strategia e iniziative contro la disinformazione

La necessità di affrontare la disinformazione online è più urgente che mai, e uno degli sforzi più significativi in questo contesto è rappresentato dal progetto AI4TRUST. Finanziato dal programma Horizon Europe dell’Unione Europea, questo progetto si prefigge di sviluppare una piattaforma innovativa capace di unire l’intelligenza artificiale alle competenze di giornalisti e fact-checker. La sinergia tra tecnologia e verifica umana è fondamentale per creare strumenti in grado di identificare e contrastare le fake news in modo efficace. Questa iniziativa mira non solo a rilevare contenuti falsi, ma anche a educare gli utenti sull’importanza di fonti informative affidabili.

Il design della piattaforma prevede l’integrazione di algoritmi avanzati di intelligenza artificiale con processi di verifica umana, garantendo così una protezione più robusta contro le manipolazioni informative. La presentazione dei risultati ottenuti dalla piattaforma sarà pubblica, dimostrando la trasparenza e l’impegno verso una corretta informazione. In un’epoca in cui la disinformazione ha il potere di influenzare l’opinione pubblica e le decisioni politiche, iniziative come AI4TRUST rappresentano un passo cruciale verso la salvaguardia della democrazia e della verità.

In questo contesto, un evento di approfondimento si terrà il 23 marzo alle 10 nel programma di Sky TG24 “Progress”, con la partecipazione di esperti come Riccardo Gallotti, coordinatore del progetto, e Nicola Bruno, specialista in cultura digitale. In questa occasione, si discuterà dell’impatto delle tecnologie emergenti sulla disinformazione e di come le piattaforme di AI possano essere sviluppate per supportare un’informazione più accurata e responsabile.

DIRETTORE EDITORIALE

Michele Ficara Manganelli ✿

PUBBLICITA’ – COMUNICATI STAMPA – PROVE PRODOTTI

Per acquistare pubblicità CLICCA QUI

Per inviarci comunicati stampa e per proporci prodotti da testare prodotti CLICCA QUI