Consumo di energia e acqua di ChatGPT: scopri i dati sorprendenti

Consumi di energia e acqua di ChatGPT

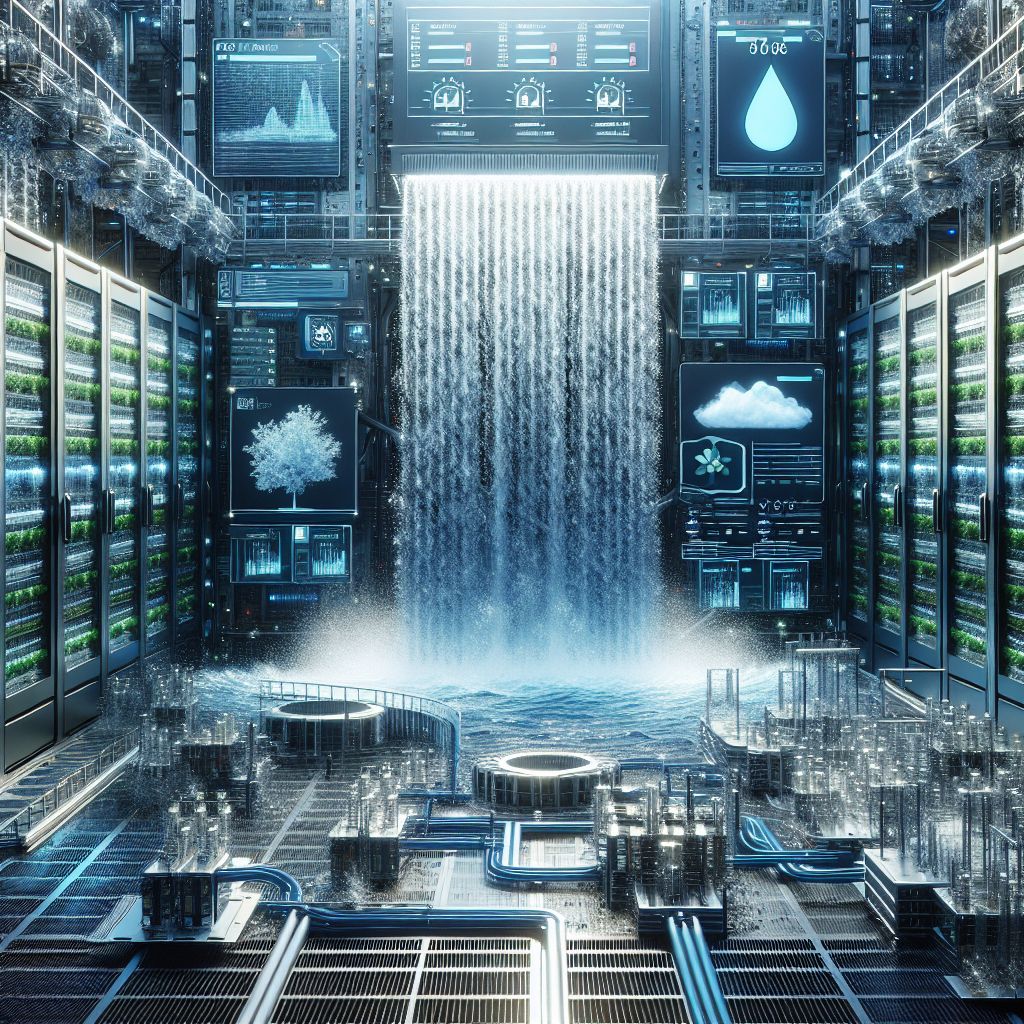

L’intelligenza artificiale generativa come ChatGPT richiede una sostanziale quantità di energia e acqua sia durante la fase di addestramento dei modelli che nei momenti di utilizzo attivo. Quando un utente richiede a ChatGPT di comporre un’email di 100 parole, la macchina elabora i prompt attraverso server ubicati in data center, con quelli di OpenAI che si trovano principalmente nei servizi Azure di Microsoft. Questo processo di elaborazione genera calore, il quale deve essere smaltito attraverso sistemi di raffreddamento che utilizzano acqua.

Il consumo di acqua varia in base alla localizzazione geografica dei data center. I ricercatori dell’Università della California (Riverside) hanno quantificato che un data center situato nello stato di Washington consuma circa 1.468 millilitri di acqua, ovvero circa 1,5 litri, per generare un’email di 100 parole. In Texas, invece, il consumo scende a 235 millilitri. Mediamente, la creazione dell’email richiede 519 millilitri d’acqua.

Se consideriamo almeno una richiesta a settimana da parte del 10% dei lavoratori americani, che corrisponde a circa 16 milioni di persone, il consumo annuo di acqua da questo servizio supera i 435 milioni di litri, una quantità equivalente all’acqua utilizzata da tutti i nuclei familiari del Rhode Island in un giorno e mezzo.

Per quanto riguarda l’energia, redigere l’email richiede 0,14 kWh, equivalenti all’accensione di 14 lampadine a LED per un’ora. Utilizzando la stessa proiezione di richieste settimanali da parte di 16 milioni di lavoratori, il consumo energetico annuale supera i 121 MW, un valore che corrisponde all’elettricità utilizzata da tutte le famiglie del District of Columbia in un periodo di 20 giorni.

Consumo energetico di ChatGPT

Il consumo energetico di ChatGPT è un aspetto cruciale per comprendere il suo impatto ambientale. Quando si elabora un testo, come nel caso di un’email di 100 parole, il modello richiede energia elettrica non solo per il funzionamento dei server, ma anche per il raffreddamento necessario a mantenere operativi i data center. Il costo energetico associato a un singolo processo di elaborazione è di 0,14 kWh, una cifra che può sembrare contenuta, ma che accumulata su una vasta scala rivela dimensioni significative.

Se esaminiamo i dati un po’ più da vicino, ci rendiamo conto che se il 10% dei lavoratori americani, ossia circa 16 milioni di persone, fa almeno una richiesta settimanale a ChatGPT, il consumo energetico annuale si attesta su una cifra oltre i 121 MW. Questo consumo è comparabile all’elettricità consumata da tutte le famiglie del District of Columbia in un periodo di 20 giorni, un’illustrazione chiara di come anche semplici interazioni quotidiane possano contribuire a un consumo energetico significativo.

Il trend mondiale vede un aumento nella domanda di modelli di AI sempre più complessi e potenti, il che porta a una crescente richiesta di energia. I data center, oltre a dover gestire un numero sempre maggiore di operazioni parallele, devono anche garantire un’efficienza energetica, affrontando così la sfida di bilanciare prestazioni e sostenibilità. Infatti, il training dei modelli di linguaggio richiede una potenza computazionale elevata, e di conseguenza, un incremento nel fabbisogno elettrico.

La generazione di energia, spesso proveniente da fonti non rinnovabili, amplifica ulteriormente la questione. Sebbene le Big Tech stiano adottando misure per ridurre le loro emissioni di gas serra, il consumo energetico associato all’IA generativa rimane un argomento di scottante attualità, evidenziando la necessità di esplorare fonti energetiche alternative e pratiche più sostenibili. Le prescrizioni regolatorie e le pressioni pubbliche per la sostenibilità continueranno probabilmente a modellare il futuro dei data center e l’uso dell’intelligenza artificiale.

Consumo di acqua nei data center

Il consumo di acqua nei data center che ospitano i servizi di intelligenza artificiale come ChatGPT è un aspetto fondamentale per valutare il loro impatto ambientale. Il calore generato dai server deve essere dissipato in modo efficace per mantenere temperature operative sicure e ottimali. A questo scopo, i sistemi di raffreddamento ad acqua vengono comunemente utilizzati. La quantità di acqua necessaria per questi sistemi varia in base alla localizzazione geografica, influenzando così i consumi.

Dai dati presentati dai ricercatori dell’Università della California (Riverside), appare chiaro che i data center possono avere un consumo d’acqua significativamente diverso in base alla regione in cui si trovano. Ad esempio, il data center situato nello stato di Washington consuma 1.468 millilitri di acqua, circa 1,5 litri, per elaborare un’email di 100 parole. In contrasto, un data center in Texas ha un fabbisogno di acqua notevolmente inferiore, che si attesta a soli 235 millilitri per la stessa operazione. Tale diversità è dovuta a fattori climatici e agli approcci specifici di raffreddamento adottati in ciascuna area.

Considerando queste informazioni, il consumo medio di acqua per generare un’email di 100 parole si aggira attorno ai 519 millilitri. Se si considera che il 10% dei lavoratori americani utilizza il servizio almeno una volta a settimana, il totale annuale di acqua consumata per queste elaborazioni raggiunge e supera i 435 milioni di litri. Questa quantità è equivalente all’acqua consumata da tutti i nuclei familiari del Rhode Island in un giorno e mezzo, un dato che evidenzia l’impatto significativo di queste tecnologie anche su risorse idriche vitali.

Il crescente utilizzo di sistemi di intelligenza artificiale genera quindi interrogativi importanti riguardo alla sostenibilità e alla gestione delle risorse. Con l’aumento della domanda di processi basati su IA, è cruciale che le aziende comprensano e implementino strategie per ottimizzare il consumo di acqua nei loro data center. La ricerca di approcci che minimizzino l’impatto idrico, integrando tecnologie più efficienti e pratiche di riciclo, sarà essenziale per affrontare le sfide ambientali nei prossimi anni.

Impatto ambientale dell’IA generativa

L’intelligenza artificiale generativa comporta tantissimi vantaggi, ma il suo impatto ambientale richiede un’attenta considerazione. I data center, che sono il cuore del funzionamento di servizi come ChatGPT, non solo consumano enormi quantità di energia e acqua, ma producono anche calore, che deve essere dissipato per garantire efficienza e sicurezza operativa. Questo ciclo di richiesta ed evasione genera una serie di sfide ecologiche che non possono essere ignorate.

Le emissioni di carbonio associate all’energia elettrica utilizzata dai data center sono un fattore cruciale. La maggior parte dell’energia proviene da fonti tradizionali, come il carbone e il gas naturale, che contribuiscono significativamente alle emissioni di gas serra. Anche se le grandi aziende tecnologiche hanno annunciato piani per migliorare la sostenibilità, l’aumento dell’uso di modelli di intelligenza artificiale solleva interrogativi sulla reale efficacia di questi sforzi. La domanda di potenza computazionale continua a crescere, rendendo difficile raggiungere obiettivi di sostenibilità ambiziosi.

Inoltre, il fabbisogno idrico dei data center è un’altra variabile da considerare. L’utilizzo eccessivo di acqua per il raffreddamento dei server potrebbe portare a tensioni idriche in regioni già vulnerabili. Secondo gli studi, in alcune aree, l’acqua utilizzata dai data center può competere con l’uso residenziale e agricolo, aggravando problemi esistenti legati alla scarsità d’acqua. Pertanto, la pianificazione per l’uso sostenibile delle risorse idriche diventa imperativa.

Il futuro dell’intelligenza artificiale, e in particolare di modelli come ChatGPT, dovrà necessariamente integrare strategie di gestione ambientale che considerino sia il consumo energetico che quello idrico. L’adozione di energie rinnovabili e l’implementazione di tecniche avanzate di raffreddamento potrebbero contribuire a ridurre l’impatto ecologico, ma richiedono investimenti significativi e un cambiamento di paradigma nel modo in cui le aziende pensano alla tecnologia e alla sostenibilità.

Confronto tra diversi modelli di intelligenza artificiale

Quando si parla di intelligenza artificiale generativa, è essenziale considerare la diversità dei modelli esistenti e il loro rispettivo impatto in termini di consumo di energia e acqua. Mentre ChatGPT rappresenta un esempio prominente, ci sono altri modelli sviluppati da aziende come Meta e Google che presentano consumi distinti e significativi. Questi modelli variano non solo per la loro architettura e le loro capacità, ma anche per l’efficienza energetica e idrica che comportano durante le fasi di addestramento e utilizzo.

Prendendo in considerazione il modello GPT-3 di OpenAI, i data center utilizzati per il suo addestramento hanno consumato oltre 700.000 litri di acqua. Questa quantità è paragonabile alla quantità necessaria per produrre circa 45 kg di carne di manzo, sottolineando l’impatto significativo dell’IA sull’uso delle risorse idriche. D’altra parte, il modello Llama 3 sviluppato da Meta ha registrato un consumo d’acqua ancora più impressionante, pari a 22 milioni di litri durante il suo training, un valore che corrisponde alla quantità d’acqua necessaria per produrre circa 2.013 kg di riso.

Queste differenze dimostrano che i consumi energetici e idrici non sono fissi e possono variare notevolmente in base alla complessità del modello, al numero di parametri e all’infrastruttura utilizzata nei data center. Modelli più grandi, che sfruttano miliardi di parametri, tendono a richiedere hardware più potente e, di conseguenza, un consumo maggiore di energia e risorse idriche.

La rivalità tra le grandi aziende tecnologiche ha portato a innovazioni rapide, ma ha anche sollevato interrogativi sulla sostenibilità. Mentre la competizione per sviluppare modelli più performanti è accesa, diventa fondamentale affrontare la questione delle risorse necessarie per alimentare questi sistemi. Le aziende devono quindi riflettere non solo sulla potenza computazionale, ma anche sulla responsabilità ambientale associata ai loro progressi tecnologici.

Future prospettive e sostenibilità nell’IA

Il futuro dell’intelligenza artificiale generativa, come ChatGPT, presenta sfide significative per quanto riguarda la sostenibilità e la gestione delle risorse. Con l’aumento della richiesta di modelli sempre più complessi e performanti, è fondamentale trovare un equilibrio tra innovazione tecnologica e responsabilità ambientale. Il settore tecnologico sta iniziando a riconoscere l’importanza di approcci più sostenibili, che non solo riducano il consumo energetico e idrico, ma che considerino anche l’impatto globale delle loro operazioni.

In risposta alle crescenti preoccupazioni ambientali, molte aziende stanno esplorando alternative energetiche, come l’integrazione di fonti rinnovabili nel loro mix energetico. Questa transizione, sebbene complessa e costosa, è cruciale per ridurre l’impatto carbonico dei data center, e molte grandi aziende tecnologiche hanno già avviato iniziative per migliorare la propria impronta ecologica. Allo stesso modo, l’ottimizzazione dei sistemi di raffreddamento e l’investimento in tecnologie crescenti nel riciclo delle risorse idriche saranno essenziali per garantire che i data center rimangano operativi senza sovraccaricare le risorse locali.

Inoltre, il settore sta cominciando a considerare l’adozione di pratiche di progettazione sostenibile per i nuovi data center, integrando tecnologie di raffreddamento più efficienti e sistemi di gestione dei rifiuti. La creazione di spazi per uffici e data center che utilizzino al meglio le risorse disponibili, come la ventilazione naturale e l’illuminazione solare, sta diventando un’area di crescente interesse.

La comunità scientifica e le istituzioni di ricerca stanno guidando sforzi per sviluppare modelli di intelligenza artificiale più efficienti, che richiedano minori quantità di energia e acqua durante le fasi di addestramento e utilizzo. Questi sviluppi potrebbero non solo contribuire a una riduzione dei consumi, ma anche spingere verso un uso più consapevole delle risorse, promuovendo un’era in cui la tecnologia e la sostenibilità possano coesistere in modo armonioso.

DIRETTORE EDITORIALE

Michele Ficara Manganelli ✿

PUBBLICITA’ – COMUNICATI STAMPA – PROVE PRODOTTI

Per acquistare pubblicità CLICCA QUI

Per inviarci comunicati stampa e per proporci prodotti da testare prodotti CLICCA QUI