Common Crawl strumenti per AI dati web mondiale guida completa per l’analisi e interrogazione avanzata

Common Crawl: la miniera di dati aperta per l’intelligenza artificiale

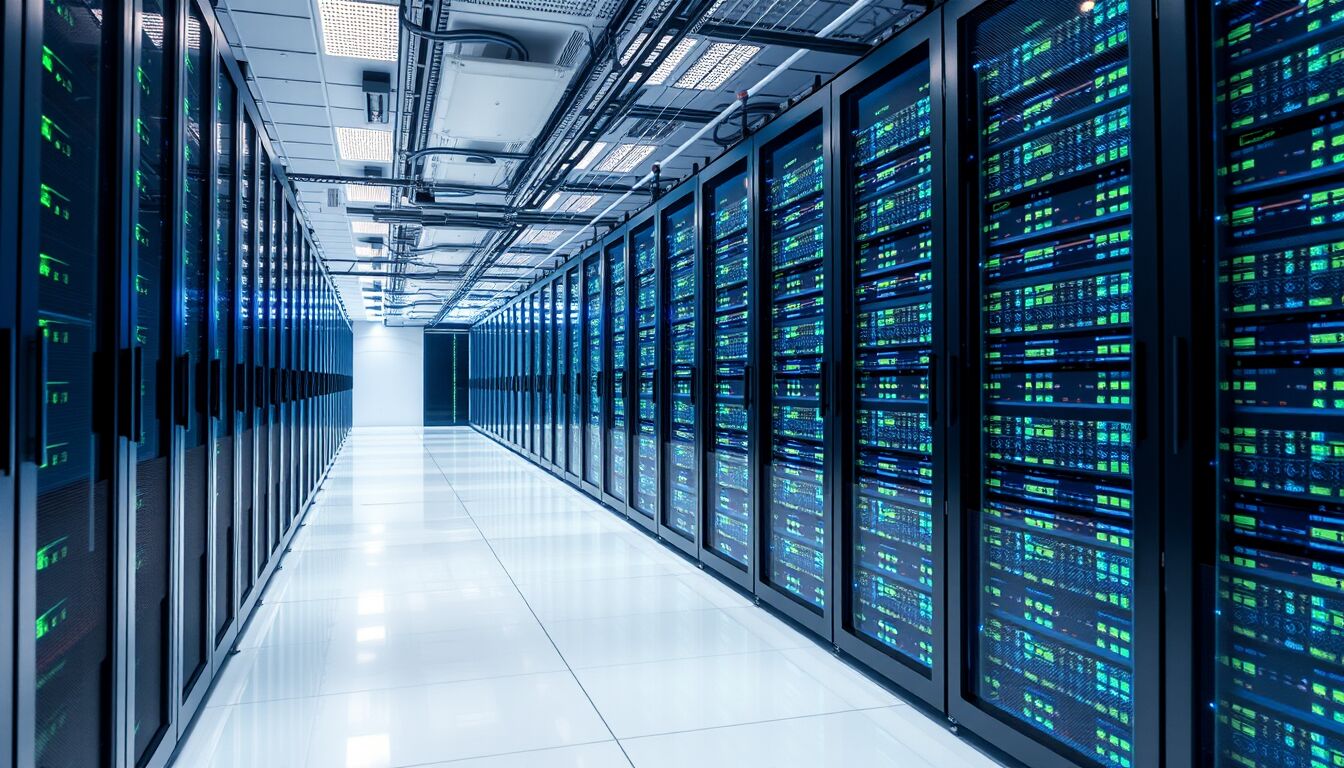

Common Crawl rappresenta una risorsa fondamentale e pubblica per chiunque desideri accedere a un vastissimo archivio testuale estratto dal Web globale. Grazie a questa piattaforma, sviluppata senza scopo di lucro e operante con cadenza mensile, è possibile analizzare miliardi di pagine Web raccolte sistematicamente in forma di testo, metadati e collegamenti ipertestuali. Questa mole di dati, che supera i petabyte, è accessibile gratuitamente a ricercatori, aziende tecnologiche e anche utenti privati muniti di un semplice account cloud. L’ampiezza e la regolarità della raccolta rendono Common Crawl una base dati primaria nella formazione e nell’addestramento dei modelli di intelligenza artificiale, integrata largamente nelle pipeline di società come OpenAI, Google e altre importanti realtà dell’AI.

L’archivio di ottobre 2025, ad esempio, contiene più di 2,61 miliardi di pagine Web archiviate, dimostrando la portata globale dell’operazione di crawling. Questa costanza e completezza di dati costituiscono un vantaggio competitivo rispetto alle infrastrutture proprietarie, spesso limitate da costi elevati e complessità legali. Common Crawl, infatti, offre una piattaforma stabile e indipendente, agevolando l’accesso a un patrimonio informativo fondamentale per lo sviluppo di modelli linguistici avanzati e per molteplici altri usi nei settori dell’analisi dati e della ricerca digitale.

Le sfide legali e i contenuti protetti nella raccolta dati

L’attività di Common Crawl si sviluppa in un terreno giuridicamente complesso. Pur dichiarando di raccogliere soltanto contenuti “liberamente disponibili” online, nel corpus esistono numerose pagine provenienti da siti protetti da paywall. Questo accade perché il crawler non esegue il codice JavaScript che abilita le restrizioni, consentendo così la lettura completa di testi riservati agli abbonati. Tale meccanismo rappresenta una falla tecnica nota: senza protezioni lato server efficaci, qualunque bot o motore di ricerca potrebbe accedere a contenuti altrimenti riservati, mettendo in difficoltà editori e produttori di contenuti originali.

Il problema si estende al dilemma etico e legale dell’utilizzo di dati protetti per l’addestramento di modelli di intelligenza artificiale. Mentre i contenuti acquisiti contribuiscono a creare sistemi sempre più performanti, non sempre vi è un riconoscimento o compenso per gli autori originali. Inoltre, i dati archiviati da Common Crawl sono immutabili per design: una volta pubblicati i file WARC, non è possibile rimuovere selettivamente informazioni sensibili o protette, rendendo persistente questo materiale in un archivio globale e aperto.

Questo scenario pone questioni critiche riguardanti la tutela del copyright, la responsabilità di chi gestisce la raccolta dati e l’equilibrio tra accesso aperto e rispetto dei diritti degli editori. Common Crawl si configura quindi come un contesto giuridico e tecnico sfumato, dove la trasparenza e la condivisione del sapere si confrontano con le esigenze di protezione delle fonti originali, alimentando un dibattito attuale e destinato a evolversi con l’avanzare delle tecnologie digitali.

Interrogare il Web mondiale: strumenti e potenzialità di Common Crawl

Common Crawl offre un accesso senza precedenti a una mole immensa di dati Web, ma la sua piena valorizzazione richiede strumenti avanzati e competenze specifiche. La sfida principale risiede nell’immagazzinamento e nella gestione di petabyte di dati non strutturati, archiviati in formato WARC: un archivio che, senza metodologie idonee, risulta difficile da esplorare efficacemente. La soluzione più efficace per interrogare rapidamente e senza sforzo l’intero corpus consiste nell’utilizzo di servizi cloud come AWS Athena, un sistema di analisi interattiva e serverless che consente di formulare query SQL direttamente sui dati contenuti nei bucket S3 di Common Crawl.

Attraverso Athena, è possibile eseguire ricerche altamente specifiche, come individuare pagine Web contenenti particolari termini, analizzare pattern di link o rintracciare siti caratterizzati da configurazioni tecnologiche comuni. Il vantaggio cruciale di questa modalità è che l’accesso ai dati non comporta una scansione attiva dei siti Web, evitando quindi problemi di sovraccarico dei server o violazioni dirette. Ciò rende Common Crawl uno strumento insostituibile per operazioni di Information Gathering nel campo della sicurezza informatica e della ricerca OSINT, facilitando estrazioni di dati prima irraggiungibili su scala globale.

Inoltre, le query eseguite su Athena possono essere salvate, richiamate e scaricate in formati tabellari come CSV, semplificando ulteriormente l’analisi esterna e l’integrazione dei risultati nei flussi di lavoro dei data scientist o degli analisti digitali. Grazie a questa infrastruttura, è possibile scoprire correlazioni complesse tra siti, monitorare contenuti specifici o persino verificare la diffusione di tecnologie Web e policy di sicurezza adottate nei vari domini. In sintesi, Common Crawl, combinato con potenti strumenti di interrogazione, trasforma un vasto archivio statico in una risorsa dinamica e strategica per l’analisi del Web mondiale.

DIRETTORE EDITORIALE

Michele Ficara Manganelli ✿

PUBBLICITA’ – COMUNICATI STAMPA – PROVE PRODOTTI

Per acquistare pubblicità CLICCA QUI

Per inviarci comunicati stampa e per proporci prodotti da testare prodotti CLICCA QUI