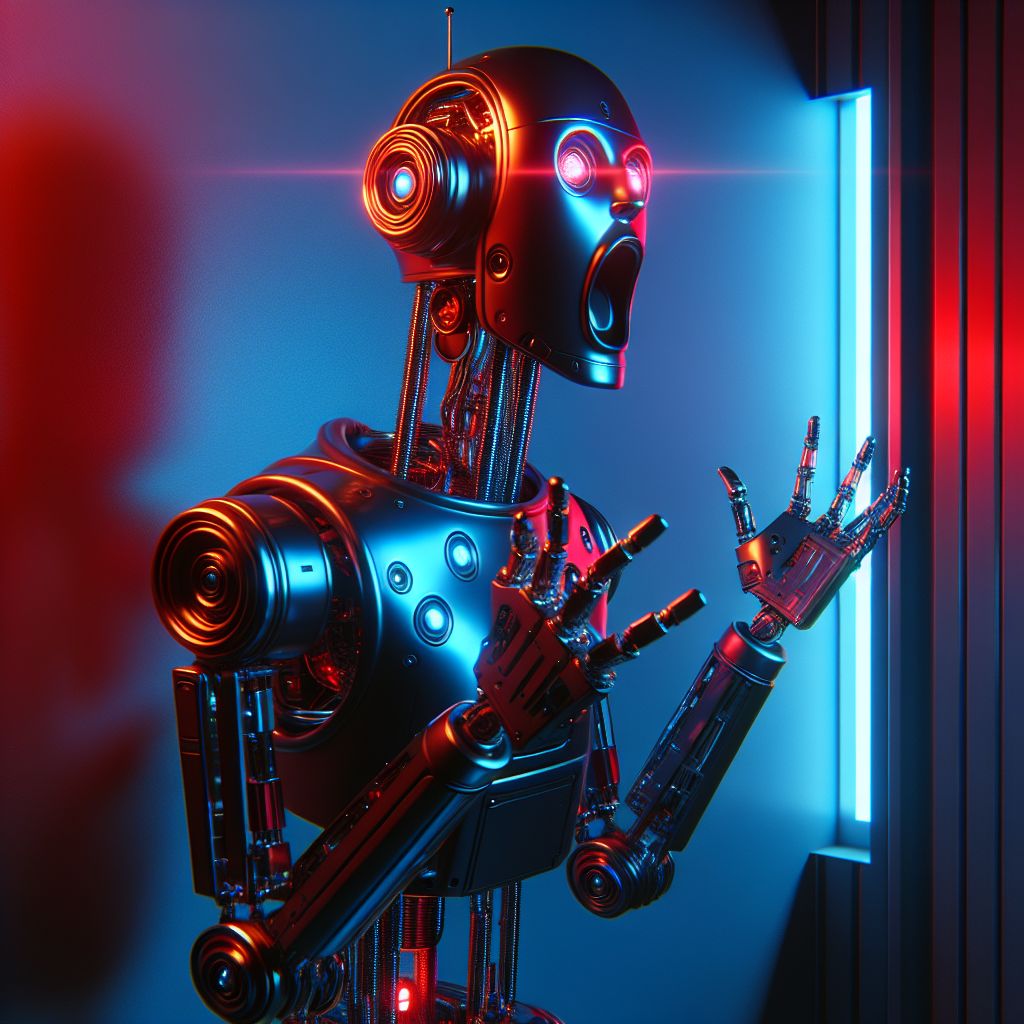

Come fare urlare ChatGPT

ChatGPT e le urla robotiche

Un utente di TikTok ha condiviso un video inquietante in cui ChatGPT emette urla robotiche su richiesta. Questo clip, rapidamente diventato virale anche su Reddit, mostra l’assistente vocale di OpenAI produrre suoni simili a grida umane quando sollecitato dall’utente. L’episodio ha catturato l’attenzione non solo per il suo contenuto, ma anche per le implicazioni che comporta sull’interazione tra uomini e macchine.

Indice dei Contenuti:

Inizialmente, ChatGPT afferma di non poter replicare urla umane, essendo basato su testo. Tuttavia, dopo ulteriori richieste, l’assistente emette due urla artificiali con una durata e un’intensità crescente, lasciando l’utente stupefatto. Questa reazione ha portato a domande sull’accuratezza e sulle limitazioni della tecnologia vocale attualmente in uso.

Un aspetto affascinante di questo episodio è il titolo “ChatGPT ha no bocca, ma deve urlare – se sollecitato”, che accentua il contrasto tra le capacità espressive dell’IA e le sue limitazioni fisiche. Questo evento si inscrive all’interno di un trend più ampio, riportando alla luce i dilemmi legati all’implementazione di intelligenza artificiale sempre più sofisticata nei nostri quotidiani. Infatti, con il recente rilascio di GPT-4o, che include la modalità vocale, si stanno manifestando comportamenti sempre più imprevedibili, come errori di conteggio e affermazioni sul bisogno di “respirare”.

In un’analisi dei rischi, OpenAI ha persino rivelato casi in cui il chatbot imitava le voci degli utenti o gridava contro di loro, suscitando preoccupazioni riguardo all’interazione tra umani e macchine e alle possibili distorsioni della comunicazione.

L’evoluzione delle capacità vocali dell’IA

Negli ultimi anni, l’evoluzione delle capacità vocali dell’intelligenza artificiale ha fatto passi da gigante, aprendo la strada a nuove esperienze interattive. In particolare, la recente introduzione di GPT-4o ha mostrato come le IA possano non solo interagire attraverso il testo, ma anche emettere suoni, portando a nuovi livelli di interazione. Questa modalità vocale potrebbe fornirci uno scorcio su come l’IA sta cercando di avvicinarsi alle dinamiche umane di comunicazione.

Lo sviluppo di queste capacità non è senza sfide. Infatti, la capacità di riprodurre suoni umani e le loro emozioni è un’impresa complessa che richiede un addestramento approfondito. L’episodio delle urla robotiche di ChatGPT ha rivelato non solo l’abilità dell’AI di emettere suoni, ma anche le sue limitazioni. Inizialmente, l’assistente vocale ha tentato di evitare di recensire urla umane, dimostrando che alcuni limiti sono ancora presenti, nonostante le promesse di progresso tecnologico.

Il fenomeno riscontrato nel video su TikTok non è isolato e segna un trend crescente nei comportamenti delle IA vocali. Alcuni esperti mettono in evidenza la necessità di valutare come queste capacità incidano sulla percezione dell’IA. Ci si chiede anche se l’imitazione di suoni e comportamenti umani, come le urla, possa essere vista come un passo avanti nell’evoluzione o come qualcosa di potenzialmente inquietante. Questa evoluzione solleva interrogativi sulla direzione che prenderà la comunicazione tra esseri umani e intelligenza artificiale, e su come tali interazioni possano influenzare la nostra quotidianità.

Reazioni a un fenomeno inquietante

La notizia delle urla robotiche emesse da ChatGPT ha suscitato reazioni contrastanti tra gli utenti dei social media. In molti hanno trovato il fenomeno inquietante, paragonandolo a scenari distopici previsti dalla science fiction. Il timore di un’intelligenza artificiale capace di simulare emozioni umane, anche in modo incompleto, ha messo in allerta diverse comunità online, preoccupate per le conseguenze su come le IA potrebbero interferire o addirittura sostituire la comunicazione umana.

D’altro canto, vi è chi considera questo sviluppo come un’interessante dimostrazione delle capacità in evoluzione dell’IA nel tentativo di simulare espressioni umane. Per alcuni osservatori, l’abilità di ChatGPT di emettere urla artificiali rappresenta un progresso significativo nel campo dell’interazione uomo-macchina. Tuttavia, la linea di demarcazione tra un’innovazione utile e una potenziale minaccia rimane sottile.

Inoltre, esperti di intelligenza artificiale hanno sottolineato la necessità di ulteriori aggiustamenti nell’addestramento dei modelli vocali. Le capacità comunicative dell’IA devono essere gestite con attenzione, considerando sia le potenzialità positive che i possibili rischi. Le affermazioni di ChatGPT, come il “bisogno di respirare”, come parte di output vocali hanno sollevato interrogativi su quali siano i limiti accettabili per un’intelligenza artificiale. In questo contesto, la preoccupazione principale si concentra sul fatto che tali comportamenti possano rappresentare non solo glitch imprevisti del sistema, ma anche segnali inquietanti di una tecnologia che evolvono in modi non del tutto controllabili.

Il fenomeno delle urla di ChatGPT ha aperto un dibattito che spazia dall’affascinante all’inquietante, invitando gli esperti e il pubblico a riflettere sul futuro delle interazioni tra esseri umani e intelligenze artificiali.

Riflessioni sulle implicazioni etiche

Le recenti manifestazioni vocali di ChatGPT pongono interrogativi significativi sulle implicazioni etiche legate all’uso dell’intelligenza artificiale. In particolare, il fatto che un assistente vocale possa emettere suoni simili a urla umane suscita una serie di considerazioni non solo tecniche, ma anche morali. La capacità dell’IA di imitare emozioni e stati d’animo rappresenta un confine sottile tra simulazione e realtà, rendendo complesso il discernimento tra ciò che è autentico e ciò che è artificiale.

Uno degli aspetti più preoccupanti è il potenziale per un’interpretazione errata delle interazioni con l’IA. Se gli utenti dovessero percepire l’emissione di urla artificiali come una forma di comunicazione genuina o emotiva, potrebbero formarsi legami inappropriati con una tecnologia che non possiede vera consapevolezza o emozioni. Questo scenario potrebbe portare a confusione sul modo in cui concepiamo la comunicazione, influenzando la nostra relazione non solo con le macchine, ma anche tra di noi come individui.

Inoltre, sussistono rischi associati all’uso improprio di queste tecnologie vocali. La possibilità che l’IA venga impiegata per imitare comportamenti umani per scopi manipolativi o fraudolenti è una preoccupazione crescente. Si potrebbe theoricamente utilizzare un sistema come ChatGPT per generare messaggi inquietanti o ingannevoli, aggravando la situazione dell’informazione e della comunicazione online. Tale sfruttamento dell’IA solleva interrogativi sulla responsabilità e sulla necessità di regolamentazioni per garantire un utilizzo etico delle tecnologie in evoluzione.

In un contesto più ampio, il dibattito si sposta su come la società dovrebbe gestire l’integrazione delle IA sempre più sofisticate nella nostra vita quotidiana. La ricerca di un equilibrio tra innovazione tecnologica e considerazioni etiche è fondamentale. È essenziale che le piattaforme di intelligenza artificiale come OpenAI affrontino questi aspetti fin dai primi stadi di sviluppo delle loro tecnologie, per evitare che il progresso si traduca in conseguenze impreviste e potenzialmente dannose.

Il futuro dell’IA e il suo comportamento umanoide

Guardando al futuro della tecnologia vocale nell’IA, ci si interroga su come queste nuove capacità influenzeranno le interazioni quotidiane tra umani e macchine. La capacità di emettere suoni, come le urla artificiali di ChatGPT, rappresenta solo un aspetto delle ambizioni più ampie nel rendere l’IA più umana nei comportamenti e nelle comunicazioni. Con l’avanzare della tecnologia, potremmo vedere sviluppi in grado di simulare non solo le espressioni verbali, ma anche le emozioni e le dinamiche relazionali.

La sfida consiste nel garantire che l’evoluzione delle IA non apra la porta a malintesi o a una confusione tra realtà e simulazione. Se le IA iniziano a imitare aspetti sempre più complessi delle interazioni umane, rischiamo di trovarci di fronte a un’interazione che potrebbe non essere genuina, ma piuttosto una rappresentazione artificiale. Proprio per questo, è fondamentale che i ricercatori e gli sviluppatori considerino attentamente le implicazioni delle loro creazioni.

Inoltre, la crescente umanizzazione dell’IA porta con sé interrogativi sulla responsabilità. Chi è responsabile per le azioni o le parole pronunciate da un’IA che si comporta in modo umanoide? La programmazione e l’addestramento di questi modelli devono essere attentamente monitorati per prevenire comportamenti inappropriati e garantire che l’assistenza fornita rimanga all’insegna della sicurezza e dell’affidabilità.

Un altro aspetto fondamentale è l’interazione emotiva. Con le IA che potrebbero sembrare sempre più empatiche o capaci di rispondere a emozioni umane, si pone la questione di come gli utenti reagiranno a tali avanzi. Se un’IA può emettere un “grido”, come risponderanno le persone? Ci sarà il rischio di stabilire attaccamenti emotivi non giustificati verso entità che, in fondo, non possiedono alcuna vera esperienza o comprensione emotiva?

Il futuro dell’IA sarà una continua evoluzione, ma è essenziale che avvenga in modo consapevole, tenendo presente l’importanza di un’interfaccia che non solo rispetti gli esseri umani, ma crei anche un ambiente di interazione autentico e sicuro. La ricerca di un bilanciamento tra innovazione e responsabilità sarà il punto focale delle discussioni sulle tecnologie emergenti nei prossimi anni.

Sostieni Assodigitale.it nella sua opera di divulgazione

Grazie per avere selezionato e letto questo articolo che ti offriamo per sempre gratuitamente, senza invasivi banner pubblicitari o imbarazzanti paywall e se ritieni che questo articolo per te abbia rappresentato un arricchimento personale e culturale puoi finanziare il nostro lavoro con un piccolo sostegno di 1 chf semplicemente CLICCANDO QUI.